Tarjeta gráfica

| Tarjeta gráfica | ||

|---|---|---|

Una Radeon HD 5570, una tarjeta gráfica PCI Express con salidas VGA, HDMI y DVI y un conjunto de disipador con un pequeño ventilador para la refrigeración | ||

| Información | ||

| Tipo | periférico | |

| Fabricante | ||

| Se conecta a | ||

| Placa base | ||

| Pantalla | ||

Una tarjeta gráfica o tarjeta de video es una tarjeta de expansión de la placa base de la computadora que se encarga de procesar los datos provenientes del procesador y transformarlos en información comprensible y representable en el dispositivo de salida (por ejemplo: monitor, televisor o proyector). Estas tarjetas utilizan una unidad de procesamiento gráfico o GPU, que muchas veces se usa erróneamente para referirse a la tarjeta gráfica en sí. También se les conoce como Adaptador de pantalla, Adaptador de vídeo, Placa de vídeo, y Tarjeta aceleradora de gráficos.

Una tarjeta de video permite al usuario en términos generales jugar videojuegos, usar aplicaciones de edición de filtros como:

- PhotoDirector.

- Canva.

- VSCO.

- Adobe Lightroom.

- Snapseed. aplicaciones de edición de vídeo como Adobe Premiere o DaVinci Resolve y aplicaciones de dibujo asistido por computador como AutoCAD, Revit y ArchiCAD. También sirven para minar criptomonedas.

Algunas tarjetas gráficas han ofrecido funcionalidades añadidas como sintonización de televisión, captura de vídeo, decodificación[1] MPEG-2 y MPEG-4, o incluso conectores IEEE 1394 (Firewire), de mouse, lápiz óptico o joystick.

Las tarjetas gráficas más comunes son las disponibles para el ordenador compatibles con la IBM PC, debido a la enorme popularidad de estas, pero otras arquitecturas también hacen uso de este tipo de dispositivos.

Las tarjetas gráficas no son dominio exclusivo de los ordenadores personales (PC) compatibles IBM; contaron o cuentan con ellas dispositivos como por ejemplo: Commodore Amiga (conectadas mediante las ranuras Zorro II y Zorro III), Apple II, Apple Macintosh, Spectravideo SVI-328, equipos MSX y en las videoconsolas modernas, como la Nintendo Switch, la PlayStation 4 y la Xbox One.

Gráficos dedicados y gráficos integrados

[editar]

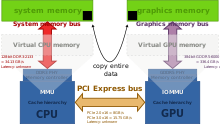

Como una alternativa a las placas de vídeo, hardware de vídeo puede ser integrado a la placa madre o a la Unidad central de procesamiento. Ambos acercamientos pueden entenderse como gráficos integrados. Casi todas las computadoras con gráficos integrados a la placa madre pueden desactivar la función de dicho chip en la BIOS, y tienen una entrada PCI, o PCI Express (PCI-E) para añadir una tarjeta de mayor rendimiento en lugar de gráficos integrados. La capacidad de deshabilitar gráficos integrados a veces también permite el uso de una placa madre en la cual el componente gráfico falló. A veces ambos tipos de gráficos (dedicados e integrados) pueden ser usados simultáneamente para distintas funciones. Las principales ventajas de los gráficos integrados son el costo, la compacidad, simpleza y bajo consumo de energía. La desventaja en rendimiento de los gráficos integrados es que utilizan recursos de la CPU. Una tarjeta gráfica posee su propia memoria RAM, su propio sistema de ventilación, y reguladores eléctricos dedicados, con todos los componentes diseñados específicamente para procesar imágenes de vídeo. Mejorar a gráficos dedicados libera trabajo de la CPU y la memoria RAM del sistema, así que no solo el procesamiento de gráficos será más rápido, también el rendimiento general de la computadora podría mejorar.

Los dos fabricantes mayoritarios de CPU, AMD e Intel, están invirtiendo más en procesadores con gráficos integrados. Una de las principales razones es que los procesadores gráficos son muy buenos en procesamiento paralelo, y ponerlos en las pastillas de la CPU permite que se puede usar su aptitud de procesamiento paralelo para distintas tareas de cómputo además de para procesamiento gráfico. AMD denomina a estas CPU como APU, y suelen ser suficientes para jugar de manera casual..

Componentes

[editar]

GPU

[editar]La GPU (acrónimo de «graphics processing unit», que significa «unidad de procesamiento gráfico») es un procesador (como la CPU) dedicado al procesamiento de gráficos; su razón de ser es aligerar la carga de trabajo del procesador central y, por ello, está optimizada para el cálculo en coma flotante, predominante en las funciones 3D. La mayor parte de la información ofrecida en la especificación de una tarjeta gráfica se refiere a las características de la GPU, pues constituye la parte más importante de la tarjeta gráfica, así como la principal determinante del rendimiento. Tres de las más importantes de dichas características son la frecuencia de reloj del núcleo, que puede oscilar entre 825 MHz en las tarjetas de gama baja, y 1600 MHz (e incluso más) en las de gama alta, el número de sombreadores y el número de tuberías (de vértices o fragmentos) encargadas de traducir una imagen 3D compuesta por vértices y líneas en una imagen 2D compuesta por píxeles.

Elementos generales de una GPU:

- Sombreadores o shaders: es el elemento más notable de potencia de una GPU, estos sombreadores unificados reciben el nombre de núcleos CUDA en el caso de NVIDIA y procesadores de flujos de datos o núcleos en su defecto en el caso de AMD. Son una evolución natural de los antiguos sombreadores de píxeles (encargados de la rasterización de texturas) y sombreadores de vértices (encargados de la geometría de los objetos), los cuales anteriormente actuaban de forma independiente, un GPU puede contener diferentes cantidades de núcleos según el tipo de GPU. Los shaders unificados son capaces de actuar como de vértices como de píxeles según la carga de trabajo que haya en la GPU, y aparecieron en el 2007 con los chips G90 de NVIDIA (Series 8000) y los chips R600 para AMD (Series HD 2000), antigua ATi, incrementando la potencia drásticamente respecto a sus familias anteriores.

- ROP: se encargan de representar los datos procesados por la GPU en la pantalla, además también es el encargado de los filtros como el de suavizado o antialiasing.

VRAM

[editar]La memoria gráfica de acceso aleatorio (VRAM) son chips de memoria que almacenan y transportan información entre sí, no son determinantes en el rendimiento máximo de la tarjeta gráfica, pero unas especificaciones reducidas pueden limitar la potencia de la GPU.

Existen memorias gráficas de dos tipos:

- Dedicada: cuando la tarjeta gráfica o la GPU dispone exclusivamente para sí esas memorias, esta manera es la más eficiente y la que mejores resultados da.

- Compartida: cuando se utiliza memoria en detrimento de la memoria de acceso aleatorio (VRAM).

Las características de memoria gráfica de una tarjeta gráfica se expresan en tres características:

- Capacidad: la capacidad de la memoria determina el número máximo de datos y texturas procesadas, una capacidad insuficiente se traduce en un retardo a espera de que se vacíen esos datos. Sin embargo es un valor muy sobrevalorado como estrategia recurrente en mercadotecnia para engañar al consumidor, tratando de hacer creer que el rendimiento de una tarjeta gráfica se mide por la capacidad de su memoria. Es una métrica importante en resoluciones grandes (Superiores a 1440p) y monitores múltiples ya que cada imagen toma mucho más espacio en la VRAM.

- Interfaz de memoria: también denominado bus de datos, es la multiplicación resultante del ancho de bits de cada chip por su número de unidades. Es una característica importante y determinante, junto a la frecuencia de la memoria, a la cantidad de datos que puede transferir en un tiempo determinado, denominado ancho de banda. Una analogía al ancho de banda se podría asociar al ancho de una autopista o carriles y al número de vehículos que podrían circular a la vez. La interfaz de memoria se mide en bits.

- Frecuencia de memoria: es la frecuencia a la que las memorias pueden transportar los datos procesados, por lo que es complemento a la interfaz de memoria para determinar el ancho de banda total de datos en un tiempo determinado. Continuando la analogía de la circulación de los vehículos de la autopista, la frecuencia de memoria se traduciría en la velocidad máxima de circulación de los vehículos, dando resultado a un mayor transporte de mercancía en un mismo periodo de tiempo. La frecuencia de las memorias se mide en hercios (su frecuencia efectiva) y se van diseñando tecnologías con más frecuencias, se destacan las adjuntas en la siguiente tabla:

| Tecnología | Frecuencia efectiva (MHz) | Ancho de banda (GB/s) |

|---|---|---|

| GDDR | 166 - 950 | 1,2 - 30,4 |

| GDDR2 | 533 - 1000 | 8,5 - 16 |

| GDDR3 | 700 - 1700 | 5,6 - 54,4 |

| GDDR4 | 1600 - 1800 | 64 - 86,4 |

| GDDR5 | 3200 - 7000 | 24 - 448 |

| GDDR6 | 12000 - 14000 | 48 - 846 |

| HBM | 500 | 512 |

| HBM2 | 500 - 1700 | 1,2 Tb/s |

- Ancho de banda (AdB): es la tasa de datos que pueden transportarse en una unidad de tiempo. Un ancho de banda insuficiente se traduce en un importante limitador de potencia de la GPU. Habitualmente se mide en gigabytes por segundo (GB/s).

- Su fórmula general es el cociente del producto de la interfaz de memoria (expresada en bits) por la frecuencia efectiva de las memorias (expresada en gigahercios), entre 8 para convertir bits a bytes.

- Por ejemplo, tenemos una tarjeta gráfica con 256 bits de interfaz de memoria y 4200 MHz de frecuencia efectiva y necesitamos hallar su ancho de banda:

Una parte importante de la memoria de un adaptador de vídeo es el z-buffer, encargado de gestionar las coordenadas de profundidad de las imágenes en los gráficos 3D, es decir, es el espacio de memoria donde se gestiona la profundidad en los gráficos.

RAMDAC

[editar]El convertidor digital-analógico de memoria de acceso aleatorio (RAMDAC) es un conversor de señal digital a señal analógica de memoria RAM. Se encarga de transformar las señales digitales producidas en el ordenador en una señal analógica que sea interpretable por el monitor. Según el número de bits que maneje a la vez y la velocidad con que lo haga, el conversor será capaz de dar soporte a diferentes velocidades de refresco del monitor (se recomienda trabajar a partir de 75 Hz, y nunca inferior a 60).[2] Dada la creciente popularidad de los monitores de señal digital, el RAMDAC está quedando obsoleto, puesto que no es necesaria la conversión analógica si bien es cierto que muchos conservan conexión VGA por compatibilidad.

Espacio que ocupan las texturas almacenadas

[editar]El espacio que ocupa una imagen representada en el monitor viene dada en función de su resolución y su profundidad de color, es decir, una imagen sin comprimir en formato estándar Full HD con 1920 × 1080 píxeles y 32 bits de profundidad de color ocuparía 66 355 200 bits, es decir, 8294 MiB.

Salidas

[editar]

Los sistemas de conexión más habituales entre la tarjeta gráfica y el dispositivo visualizador (p. ej. monitor o televisor) son:

- VGA: el video graphics array (VGA) o super video graphics array (SVGA o Súper VGA) fue el estándar analógico de los años 1990; diseñado para dispositivos con tubo de rayos catódicos (CRT); sufre de ruido eléctrico y distorsión por la conversión de digital a analógico y el error de muestreo al evaluar los píxeles a enviar al monitor. Se conecta mediante 15 pines con el conector D-sub: DE-15. Su utilización continúa muy extendida, aunque claramente muestra una reducción frente al DVI.

- DVI: digital visual interface (DVI) o interfaz visual digital es sustituta de la anterior, pero digital; fue diseñada para obtener la máxima calidad de visualización en las pantallas digitales o proyectores. Se conecta mediante pines. Evita la distorsión y el ruido al corresponder directamente un píxel a representar con uno del monitor en la resolución nativa del mismo. Cada vez más adoptado, aunque compite con el HDMI, pues el DVI no es capaz de transmitir audio.

- HDMI: la interfaz multimedia de alta definición o high-definition multimedia interface (HDMI) es una tecnología propietaria transmisora de audio y vídeo digital de alta definición cifrado sin compresión, en un mismo cable. Se conecta mediante patillas de contacto. Fue ideado inicialmente para televisores, y no para monitores, por eso no apaga la pantalla cuando deja de recibir señal y debe apagarse manualmente en caso de monitores.

- DisplayPort: puerto para tarjetas gráficas creado por VESA y rival del HDMI, transfiere vídeo a alta resolución y audio. Sus ventajas son que está libre de patentes, y por ende de regalías para incorporarlo a los aparatos, también dispone de unas pestañas para anclar el conector impidiendo que se desconecte el cable accidentalmente. Cada vez más tarjetas gráficas van adoptando este sistema, aunque sigue siendo su uso minoritario, existe una versión reducida de dicho conector llamada Mini DisplayPort, muy usada para tarjetas gráficas con multitud de salidas simultáneas, como pueden ser 5.

Otras no tan extendidas: por uso minoritario, por no ser implementadas o por ser obsoletas; son:

- S-Video (separate video, vídeo separado): implementado sobre todo en tarjetas con sintonizador TV o chips con soporte de vídeo NTSC/PAL, simplemente se está quedando obsoleto.

- Vídeo Compuesto: analógico de muy baja resolución mediante conector RCA (Radio Corporation of America). Completamente en desuso para tarjetas gráficas, aunque sigue siendo usado para TV.

- Vídeo por componentes: sistema analógico de transmisión de vídeo de alta definición, utilizado también para proyectores; de calidad comparable a la de SVGA, dispone de tres clavijas (Y, Cb y Cr). Anteriormente usado en las PC y estaciones de trabajo de gama alta, ha quedado relegado a TV y videoconsolas.

- DA-15 con conector RGB usado mayoritariamente en los antiguos Macintosh de Apple. Ya no se utiliza.

- Digital TTL con conector DE-9: usado por las primitivas tarjetas de IBM (MDA, CGA y variantes, EGA y muy contadas VGA). Completamente obsoleto.

Interfaces con la placa base

[editar]Los sistemas de conexión entre la tarjeta gráfica y la placa base han sido principalmente (en orden cronológico):

- Ranura MSX: bus de 8 bits usado en los equipos MSX.

- ISA: arquitectura de bus de 16 bits a 8 MHz, dominante durante los años 1980; fue creada en 1981 para los IBM PC.

- Zorro II: usado en los Commodore Amiga 2000 y Commodore Amiga 1500.

- Zorro III: usado en los Commodore Amiga 3000 y Commodore Amiga 4000

- NuBus: usado en el ordenador Apple Macintosh.

- Processor Direct Slot: usado en los Apple Macintosh.

- MCA: en 1987, intento de sustitución de ISA por IBM. Disponía de 32 bits y una velocidad de 10 MHz, pero era incompatible con los anteriores.

- EISA: en 1988, respuesta de la competencia de IBM; de 32 bits, 8,33 MHz y compatible con las placas anteriores.

- VESA: extensión de ISA que solucionaba la restricción de los 16 bits, duplicando el tamaño de bus y con una velocidad de 33 MHz.

- PCI: bus que desplazó a los anteriores, a partir de 1993; con un tamaño de 32 bits y una velocidad de 33 MHz, permitía una configuración dinámica de los dispositivos conectados sin necesidad de ajustar manualmente los jumpers. PCI-X fue una versión que aumentó el tamaño del bus hasta 64 bits y aumentó su velocidad hasta los 133 MHz.

- AGP: bus dedicado, de 320 bits como PCI; en 1997, la versión inicial incrementaba la velocidad hasta los 66 MHz.

- PCI-Express (PCIe): desde 2004, es la interfaz serie que empezó a competir contra AGP; en 2006, llegó a doblar el ancho de banda del AGP. Sufre de constantes revisiones multiplicando su ancho de banda, ya existen las versiones de la 1.0 hasta la actual 6.0, salida en el año 2022. No debe confundirse con PCI-X, versión de PCI.

Estas interfaces presentan diversas especificaciones;[3] las más relevantes se resumen a continuación:

| Bus | Anchura (bits) |

Frecuencia (MHz) |

Ancho de banda (MB/s) |

Puerto |

|---|---|---|---|---|

| ISA XT | 8 | 4,77 | 8 | Paralelo |

| ISA AT | 16 | 8,33 | 16 | Paralelo |

| MCA | 32 | 10 | 20 | Paralelo |

| EISA | 32 | 8,33 | 32 | Paralelo |

| VESA | 32 | 40 | 160 | Paralelo |

| PCI | 32 a 64 | 33 a 100 | 132 a 800 | Paralelo |

| AGP 1x | 32 | 66 | 264 | Paralelo |

| AGP 2x | 32 | 133 | 528 | Paralelo |

| AGP 4x | 32 | 266 | 1000 | Paralelo |

| AGP 8x | 32 | 533 | 2000 | Paralelo |

| PCIe x1 | 1*32 | 25/50 | 100/200 | Serie |

| PCIe x4 | 1*32 | 25/50 | 400/800 | Serie |

| PCIe x8 | 1*32 | 25/50 | 800/1600 | Serie |

| PCIe x16 | 1*32 | 25/50 | 1600/3200 | Serie |

| PCIe x16 2.0 | 1*32 | 25/50 | 3200/6400 | Serie |

Dispositivos refrigerantes

[editar]

Debido a las cargas de trabajo a las que son sometidas, las tarjetas gráficas alcanzan temperaturas muy altas. Si no es tenido en cuenta, el calor generado puede hacer fallar, bloquear o incluso averiar el dispositivo. Para evitarlo, se incorporan dispositivos refrigerantes que eliminen el calor excesivo de la tarjeta.

Se distinguen dos tipos:

- Disipador: dispositivo pasivo (sin partes móviles y, por tanto, silencioso); compuesto de un metal muy conductor del calor, extrae este de la tarjeta. Su eficiencia va en función de la estructura y la superficie total, por lo que a mayor demanda de refrigeración, mayor debe ser la superficie del disipador.

- Ventilador: dispositivo activo (con partes móviles); aleja el calor emanado de la tarjeta al mover el aire cercano. Es menos eficiente que un disipador, siempre que nos refiramos al ventilador solo, y produce ruido al tener partes móviles.

Aunque diferentes, ambos tipos de dispositivo son compatibles entre sí y suelen ser montados juntos en las tarjetas gráficas; un disipador sobre la GPU extrae el calor, y un ventilador sobre él aleja el aire caliente del conjunto.

La refrigeración líquida es una técnica de enfriamiento utilizando agua en vez de disipadores de calor y ventiladores (dentro del chasis), logrando así excelentes resultados en cuanto a temperaturas, y con enormes posibilidades en overclocking. Se suele realizar con circuitos de agua estancos.

El agua, y cualquier líquido refrigerante, tienen mayor capacidad térmica que el aire. A partir de este principio, la idea es extraer el calor generado por los componentes de ordenador usando como medio el agua, enfriarla una vez fuera del gabinete y luego reintroducirla.

Alimentación

[editar]Hasta ahora la alimentación eléctrica de las tarjetas gráficas no había supuesto un gran problema, sin embargo, la tendencia actual de las nuevas tarjetas es consumir cada vez más energía. Aunque las fuentes de alimentación son cada día más potentes, la insuficiencia energética se encuentra en la que puede proporcionar el puerto PCIe que solo es capaz de aportar una potencia por sí solo de 75 W.[4] Por este motivo, las tarjetas gráficas con un consumo superior al que puede suministrar la fuente, PCIe incluyen un conector PCIe[5] que permite una conexión directa entre la fuente de alimentación y la tarjeta, sin tener que pasar por la placa base, y, por tanto, por el puerto PCIe.

Aun así, se pronostica que no dentro de mucho tiempo las tarjetas gráficas podrían necesitar una fuente de alimentación propia, convirtiéndose dicho conjunto en dispositivos externos.[6]

Reseña histórica

[editar]

La historia de las tarjetas gráficas da comienzo a finales de los años 1960 cuando se pasa de usar impresoras, como elemento de visualización, a utilizar monitores. Las primeras tarjetas sólo eran capaces de visualizar texto a 40x25 u 80x25, pero la aparición de los primeros chips gráficos como el Motorola 6845 permiten comenzar a dotar a los equipos basados en bus S-100 o Eurocard de capacidades gráficas. Junto con las tarjetas que añadían un modulador de televisión fueron las primeras en recibir el término tarjeta de vídeo.

El éxito del ordenador doméstico y las primeras videoconsolas hacen que por abaratamiento de costes (principalmente son diseños cerrados), esos chips vayan integrados en la placa base. Incluso en los equipos que ya vienen con un chip gráfico se comercializan tarjetas de 80 columnas, que añadían un modo texto de 80x24 u 80x25 caracteres, principalmente para ejecutar programas CP/M (como las de los Apple II y Spectravideo SVI-328).

Curiosamente la tarjeta de vídeo que viene con el IBM PC, que con su diseño abierto herencia de los Apple II popularizará el concepto de tarjeta gráfica intercambiable, es una tarjeta de sólo texto. El adaptador monocromo de pantalla (MDA) desarrollada por IBM en 1981, trabajaba en modo texto y era capaz de representar 25 líneas de 80 caracteres en pantalla. Contaba con una memoria VRAM de 4KB, por lo que solamente podía trabajar con una página de memoria. Se usaba con monitores monocromo, de tonalidad normalmente verde.[7]

A partir de ahí, se sucedieron diversas controladoras para gráficos resumidas en la tabla adjunta.[8][9][10][11]

| Año | Modo texto | Modo gráficos | Colores | Memoria | |

|---|---|---|---|---|---|

| MDA | 1981 | 80*25 | - | 1 | 4 KiB |

| CGA | 1981 | 80*25 | 640*200 | 4 | 16 KiB |

| HGC | 1982 | 80*25 | 720*348 | 1 | 64 KiB |

| EGA | 1984 | 80*25 | 640*350 | 16 | 256 KiB |

| IBM 8514 | 1987 | 80*25 | 1024*768 | 256 | - |

| MCGA | 1987 | 80*25 | 320*200 | 256 | - |

| VGA | 1987 | 720*400 | 640*480 | 256 | 256 KiB |

| SVGA | 1989 | 80*25 | 800*600 | 256 | 1 MiB |

| XGA | 1990 | 80*25 | 1024*768 | 65 000 | 2 MiB |

El adaptador gráfico de vídeo (VGA) tuvo una aceptación masiva, lo que llevó a compañías como ATI, Cirrus Logic y S3 Graphics, a trabajar sobre dicha tarjeta para mejorar la resolución y el número de colores. Así nació el estándar Super Video Graphics Array (SVGA). Con dicho estándar se alcanzaron los 2 MB de memoria VRAM, así como resoluciones de 1024 × 768 pixeles a 256 colores.

La competencia de las PC, Commodore Amiga 2000 y Apple Macintosh reservaron en cambio esa posibilidad a ampliaciones profesionales, integrando casi siempre la GPU (que batía en potencia con total tranquilidad a las tarjetas gráficas de las PC del momento) en sus placas base. Esta situación se perpetúa hasta la aparición del bus Peripheral Component Interconnect (PCI), que sitúa a las tarjetas de PC al nivel de los buses internos de sus competidores, al eliminar el cuello de botella que representaba el bus Industry Standard Architecture (ISA). Aunque siempre por debajo en eficacia (con la misma GPU S3 ViRGE, lo que en una PC es una tarjeta gráfica avanzada deviene en acelerador 3D profesional en los Commodore Amiga con ranura Zorro III), la fabricación masiva (que abarata sustancialmente los costes) y la adopción por otras plataformas del bus PCI hace que los chips gráficos VGA comiencen a salir del mercado de la PC.

En 1995, la evolución de las tarjetas gráficas dio un giro importante con la aparición de las primeras tarjetas 2D/3D, fabricadas por Matrox, Creative, S3 y ATI, entre otros. Dichas tarjetas cumplían el estándar SVGA, pero incorporaban funciones 3D.

En 1997, 3dfx lanzó el chip gráfico Voodoo, con una gran potencia de cálculo, así como nuevos efectos 3D (mip mapping, z-buffering, antialiasing, etc.). A partir de ese punto, se suceden una serie de lanzamientos de tarjetas gráficas como Voodoo2 de 3dfx, TNT y TNT2 de NVIDIA. La potencia alcanzada por dichas tarjetas fue tal, que el puerto PCI donde se conectaban se quedó corto de ancho de banda. Intel desarrolló el Accelerated Graphics Port (AGP) que solucionaría la limitación que empezaba a aparecer entre el procesador y la tarjeta, además de intentar la incursión en el mercado de tarjetas dedicadas en 1998 con su serie i740, intento que fracasaría por el bajo rendimiento de los chips y su mala acogida en el público, por lo que provocó que este producto y su potencial sucesor el i752 fueran cancelados y descontinuados para mediados de 1999.[12]

Desde 1999 hasta 2002, NVIDIA dominó el mercado de las tarjetas gráficas (comprando incluso la mayoría de bienes de 3dfx)[13] con su gama GeForce. En ese período, las mejoras se orientaron hacia el campo de los algoritmos 3D y la velocidad de los procesadores gráficos. Sin embargo, las memorias también necesitaban mejorar su velocidad, por lo que se incorporaron las memorias DDR a las tarjetas gráficas. Las capacidades de memoria de vídeo en la época pasan de los 32 MB de GeForce, hasta los 64 y 128 MB de GeForce 4.

La mayoría de videoconsolas de sexta generación y sucesivos utilizan chips gráficos derivados de los más potentes aceleradores 3D de su momento. Los Apple Macintosh incorporan chips de NVIDIA y ATI desde el primer iMac, y los modelos PowerPC con bus PCI o AGP pueden usar tarjetas gráficas de PC con BIOS no dependientes de CPU.

En 2006, y en adelante, NVIDIA y ATI (ese mismo año comprada por AMD) se repartían el liderazgo del mercado,[14] con sus exitosas series de chips gráficos GeForce y Radeon, respectivamente.

Para 2009, Intel reintentaría una nueva incursión en el mercado de tarjetas gráficas mediante el proyecto de nombre clave "Larrabee", intento que también fracasaría como su antecesor el i740,[12][15] aunque las tecnologías desarrolladas durante dicho proyecto perdurarían como coprocesadores vectoriales especializados ya no como tarjetas gráficas, sino tarjetas de cálculos para supercomputación, lanzadas en 2012 como Xeon Phi, las cuales se discontinuarían en 2020.[16] En 2018, se informó que Intel nuevamente estaba reuniendo un equipo para desarrollar gráficos, dirigidos tanto a los centros de datos como al mercado de tarjetas para juegos de PC, y así competir con la hegemonía de los productos de GeForce de Nvidia y Radeon de AMD.[17] Producto de estos esfuerzos, nacería la arquitectura Xe en 2020, cuyo lanzamiento a la venta directa en las primeras tarjetas gráficas dedicadas de la compañía en más de 20 años, conocidas como la serie Intel Arc, ocurriría en el transcurso de 2022.[18]

Tipos antiguos de tarjetas gráficas

[editar]Tarjeta MDA

[editar]El adaptador de pantalla monocromo (MDA) fue lanzada por IBM como una memoria de 4 KiB de forma exclusiva para monitores TTL (que representaban los clásicos caracteres en ámbar o verde). No disponía de gráficos y su única resolución era la presentada en modo texto (80x25) en caracteres de 14x9 puntos, sin ninguna posibilidad de configuración.

Básicamente esta tarjeta usa el controlador de vídeo para leer de la ROM la matriz de puntos que se desea visualizar y se envía al monitor como información serie. No debe sorprender la falta de procesamiento gráfico, ya que, en estos primeros PC no existían aplicaciones que realmente pudiesen aprovechar un buen sistema de vídeo. Prácticamente todo se limitaba a información en modo texto.

Este tipo de tarjeta se identifica rápidamente ya que incluye (o incluía en su día) un puerto de comunicación para la impresora.

Tarjeta CGA

[editar]El adaptador de gráficos en color (CGA, color graphics array o color graphics adapter, según el texto al que se recurra), fue lanzado al mercado en el año 1981 también de la mano de IBM y fue muy extendido. Permitía matrices de caracteres de 8x8 puntos en pantallas de 25 filas y 80 columnas, aunque solo usaba 7 × 7 puntos para representar los caracteres. Este detalle le imposibilitaba el representar subrayados, por lo que los sustituía por diferentes intensidades en el carácter en cuestión. En modo gráfico admitía resoluciones de hasta 640 × 200 pixeles. La memoria era de 16 KiB y solamente era compatible con monitores RGB y Compuestos. A pesar de ser superior a la MDA, muchos usuarios preferían esta última dado que la distancia entre puntos de la rejilla de potencial en los monitores CGA era mayor. El tratamiento del color, por supuesto de modo digital, se realizaba con tres bits y uno más para intensidades. Así era posible lograr 8 colores con dos intensidades cada uno, es decir, un total de 16 tonalidades diferentes pero no reproducibles en todas las resoluciones tal y como se muestra en el cuadro adjunto.

Esta tarjeta tenía un fallo bastante habitual y era el conocido como efecto nieve. Este problema era de carácter aleatorio y consistía en la aparición de nieve en la pantalla (puntos brillantes e intermitentes que distorsionaban la imagen). Tanto era así que algunos BIOS de la época incluían en sus ajustes la opción de eliminación de nieve.

Tarjeta HGC

[editar]La tarjeta de gráficos Hércules (Hercules graphics card, HGC), o más popularmente conocida como Hércules (nombre de la empresa productora), lanzado en el año 1982, con gran éxito convirtiéndose en un estándar de vídeo a pesar de no disponer del soporte de las rutinas de la BIOS por parte de IBM. Su resolución era de 720 × 348 puntos en monocromo con 64 KiB de memoria. Al no disponer de color, la única misión de la memoria es la de referenciar cada uno de los puntos de la pantalla usando 30,58 KiB para el modo gráfico (1 bit × 720 × 348) y el resto para el modo texto y otras funciones. Las lecturas se realizaban a una frecuencia de 50 HZ, gestionadas por el controlador de vídeo 6845. Los caracteres se dibujaban en matrices de 14x9 puntos.

Diseñadores, fabricantes y ensambladores

[editar]En el mercado de las tarjetas gráficas se distinguen tres tipos de empresa:

- Diseñadores de GPU: diseñan y generan exclusivamente la GPU. Los tres más importantes son:

- AMD (Advanced Micro Devices), anteriormente conocida como ATI Technologies (ATi) con la serie Radeon.

- NVIDIA con la serie GeForce.

- Intel con la serie Arc; también se destaca además en crear durante años GPU integradas en los chipset de la placa base y en los SOC de sus procesadores.

- Otros fabricantes como Matrox o S3 Graphics tienen una cuota de mercado muy reducida. Todos ellos contratan y encargan a fabricantes ciertas unidades de chips a partir de un diseño.

- Fabricantes de GPU: son quienes fabrican y suministran las unidades extraídas de las obleas de chips a los ensambladores. TSMC y GlobalFoundries son claros ejemplos.

- Ensambladores: integran las GPU proporcionadas por los fabricantes con el resto de la tarjeta, de diseño propio. De ahí que tarjetas con el mismo chip tengan formas o conexiones diferentes o puedan dar ligeras diferencias de rendimientos, en especial tarjetas gráficas modificadas o subidas de fábrica.

En la siguiente tabla se muestra una relación de los dos diseñadores de chips y algunos de los ensambladores de tarjetas con los que trabajan.

| Diseñadores de GPU | |||

|---|---|---|---|

| AMD | NVIDIA | Intel | |

| Ensambladores de Tarjetas | ASUS | ASUS | ACER |

| CLUB3D | CLUB3D | ASROCK | |

| GIGABYTE | GIGABYTE | GUNNIR | |

| MSI | MSI | SPARKLE | |

| POWERCOLOR | EVGA | - | |

| GECUBE | POINT OF VIEW | - | |

| XFX | GAINWARD | - | |

| SAPPHIRE | ZOTAC | - | |

| HIS | ECS ELITEGROUP | - | |

| DIAMOND | PNY | - | |

| - | GALAXY | - | |

| - | PALIT | ||

| - | - | - | |

API para gráficos

[editar]A nivel de programador, trabajar con una tarjeta gráfica es complicado; por ello, surgieron interfaces de programación de aplicaciones (API) que abstraen la complejidad y diversidad de las tarjetas gráficas. Los dos más importantes son:

- Direct3D: lanzada por Microsoft en 1996, forma parte de la librería DirectX. Funciona solo para Windows, ya que es privativa. Utilizado por la mayoría de los videojuegos comercializados para Windows. Actualmente van por la versión 12.

- OpenGL: creada por Silicon Graphics a principios de los años 1990; es gratuita, libre y multiplataforma. Utilizada principalmente en aplicaciones de CAD, realidad virtual o simulación de vuelo. Actualmente está disponible la versión 4.3.

OpenGL está siendo desplazada del mercado de los videojuegos por Direct3D, aunque haya sufrido muchas mejoras en los últimos meses.

Efectos gráficos

[editar]Algunas de las técnicas o efectos habitualmente empleados o generados mediante las tarjetas gráficas pueden ser:

- Antiescalonamiento: retoque para evitar el aliasing, escalonamiento o bordes de sierra, efecto que aparece al representar curvas y rectas inclinadas en un espacio discreto y finito como son los píxeles del monitor.

- Sombreado: procesado de píxeles y vértices para efectos de iluminación, fenómenos naturales y superficies con varias capas, entre otros.

- Renderizado de alto rango dinámico (HDR): técnica novedosa para representar el amplio rango de niveles de intensidad de las escenas reales (desde luz directa hasta sombras oscuras). Es una evolución del efecto de brillo o bloom, aunque a diferencia de este, no permite suavizado de bordes.

- Mapeado de texturas: técnica que añade detalles en las superficies de los modelos, sin aumentar la complejidad de los mismos.

- Desenfoque de movimiento: efecto de emborronado debido a la velocidad de un objeto en movimiento.

- Desenfoque de profundidad: efecto de emborronado adquirido por la lejanía de un objeto.

- Destello de lente: imitación de los destellos producidos por las fuentes de luz sobre las lentes de la cámara.

- Efecto Fresnel o imagen especular (reflejo especular): reflejos sobre un material dependiendo del ángulo entre la superficie normal y la dirección de observación. A mayor ángulo, más reflectante.

- Teselado: consiste en multiplicar el número de polígonos para representar ciertas figuras geométricas y no se vean totalmente planas. Esta característica fue incluida en la API DirectX 11

Errores comunes

[editar]- Confundir la GPU con la tarjeta gráfica. Aunque muy importante, no todas las GPU y placas de videos van en tarjeta, ni son el único determinante de su calidad y rendimiento. Es decir, las GPU sí determinan el rendimiento máximo de la tarjeta, pero su rendimiento puede ser capado por tener otros elementos que no estén a su altura (por ejemplo un pequeño ancho de banda).

- Considerar el término tarjeta de vídeo como privativo de las PC y compatibles. Esas tarjetas se usan en equipos que no son PC e incluso sin procesador Intel o AMD, y sus chips en videoconsolas.

- Confundir al diseñador de la GPU con la marca de la tarjeta. Actualmente en el mercado, NVIDIA y AMD (anteriormente ATi Tecnologies) son los mayores diseñadores de chips gráficos para PC. Ellos solamente se encargan de diseñar los chip gráficos (GPU). Luego, las empresas como TSMC o GlobalFoundries fabrican las GPU, y más tarde, para su venta al público son ensambladas en PCB con memorias, por: ASUS, POV, XFX, Gigabyte, Sapphire y demás ensambladoras (aunque la versión de referencia que sale primero la fábrica el diseñador y más tarde, las ensambladoras sacan sus versiones).

- Saliendo del círculo de las PC, para otros dispositivos como teléfonos inteligentes, la mayoría de las GPU vienen integradas en los sistemas en chip (SoC) junto al procesador y el controlador de memoria.

Véase también

[editar]- Adaptador (informática)

- Anexo:Conectores de video

- Controlador de dispositivos gráficos de fuente abierta y libre

- Factor de forma

- Gráficos 3D por ordenador

- PC 99

- Ranura de expansión

- Monitor de computadora

- Placa base

- Tarjeta de expansión

Referencias

[editar]- ↑ «Decodificación MPEG-2». Archivado desde el original el 12 de febrero de 2007. Consultado el 17 de febrero de 2007.

- ↑ «Velocidad de refresco recomendada que debe soportar el RAMDAC».

- ↑ «Características de PCIe». Archivado desde el original el 26 de marzo de 2007. Consultado el 18 de febrero de 2007.

- ↑ «Solución al suministro de energía». Archivado desde el original el 5 de diciembre de 2009. Consultado el 17 de febrero de 2007.

- ↑ «Conector de corriente para PCIe». The Inquirer (en inglés). 18 de enero de 2007. Archivado desde el original el 4 de marzo de 2008.

- ↑ «Futuras tarjetas gráficas externas y con fuente propia».

- ↑ «MDA en IBM PC». Archivado desde el original el 2 de febrero de 2007. Consultado el 17 de febrero de 2007.

- ↑ «Referencia Tabla Historia (1)».

- ↑ «Referencia Tabla Historia (2)».

- ↑ «Referencia Tabla Historia (3)».

- ↑ «Referencia Tabla Historia (4)». Archivado desde el original el 27 de septiembre de 2007.

- ↑ a b «Evolution Of Intel Graphics: i740 To Iris Pro | Tom's Hardware». www.tomshardware.com (en inglés).

- ↑ «3dfx vende activos a NVIDIA». Archivado desde el original el 21 de octubre de 2006.

- ↑ «NVIDIA vs ATI». Archivado desde el original el 22 de abril de 2007.

- ↑ Smith, Ryan (25 de mayo de 2010). «Intel Kills Larrabee GPU, Will Not Bring a Discrete Graphics Product to Market». AnandTech.

- ↑ Hruska, Joel (8 de mayo de 2019). «Intel Quietly Kills Off Xeon Phi». ExtremeTech (en inglés). Consultado el 10 de diciembre de 2022.

- ↑ Evangelho, Jason (11 de abril de 2018), «Intel Is Developing A Desktop Gaming GPU To Fight Nvidia, AMD», Forbes (en inglés), consultado el 10 de diciembre de 2022.

- ↑ «Intel Introduces New High-Performance Graphics Brand: Intel Arc». Intel (en inglés). Archivado desde el original el 16 de marzo de 2022. Consultado el 29 de agosto de 2021.

Enlaces externos

[editar] Wikimedia Commons alberga una galería multimedia sobre Tarjeta gráfica.

Wikimedia Commons alberga una galería multimedia sobre Tarjeta gráfica.- Sitio web oficial de NVIDIA

- Sitio web oficial de AMD (antes ATI)

- Demostración de varios efectos gráficos

- Moore Threads, la primera tarjeta gráfica GPU doméstica de China

- Instalar Drivers de Video Intel, ATI y Nvidia en Linux

- Guías de iniciación a las tarjetas gráficas (en inglés) (enlace roto disponible en Internet Archive; véase el historial, la primera versión y la última).

- Overclocking de tarjetas gráficas (en inglés)

- Características más importantes de una tarjeta gráfica