Diferencia entre revisiones de «Dragado de datos»

Función de sugerencias de enlaces: 2 enlaces añadidos. Etiquetas: Revertido Edición visual Edición desde móvil Edición vía web móvil Tarea para novatos Sugerencia: añadir enlaces |

m Revertidos los cambios de Wiki Saltar xd (disc.) a la última edición de Rafstr Etiquetas: Reversión Revertido |

||

| Línea 6: | Línea 6: | ||

El proceso de dragado de datos implica probar múltiples hipótesis utilizando un único [[conjunto de datos]] mediante una [[búsqueda de fuerza bruta]], tal vez de combinaciones de variables que podrían mostrar una [[correlación]], y tal vez de grupos de casos u observaciones que muestran diferencias en su media o en su desglose por alguna otra variable. |

El proceso de dragado de datos implica probar múltiples hipótesis utilizando un único [[conjunto de datos]] mediante una [[búsqueda de fuerza bruta]], tal vez de combinaciones de variables que podrían mostrar una [[correlación]], y tal vez de grupos de casos u observaciones que muestran diferencias en su media o en su desglose por alguna otra variable. |

||

Las pruebas convencionales de [[significación estadística]] se basan en la probabilidad de que surja un resultado particular si solo actuara el azar, y necesariamente aceptan cierto riesgo de conclusiones erróneas de cierto tipo (rechazos erróneos de la [[hipótesis nula]]). Este nivel de riesgo se denomina [[Significación estadística|''significación estadística'']]. Cuando se realizan una gran cantidad de pruebas, algunas arrojan resultados falsos de este tipo; por lo tanto, se podría informar (erróneamente) que el 5% de las hipótesis elegidas al azar son estadísticamente significativas al nivel de significancia del 5%, se podría informar (erróneamente) que el 1% es estadísticamente significativa al nivel de significancia del 1%, y así sucesivamente, sólo por casualidad. Cuando se prueban suficientes hipótesis, es prácticamente seguro que algunas serán estadísticamente significativas (aunque esto sea engañoso), ya que casi todos los conjuntos de datos con algún grado de aleatoriedad probablemente contengan (por ejemplo) algunas [[Relación espuria|correlaciones espurias]]. Si no son cautelosos, estos resultados pueden engañar fácilmente a los investigadores que utilizan técnicas de |

Las pruebas convencionales de [[significación estadística]] se basan en la probabilidad de que surja un resultado particular si solo actuara el azar, y necesariamente aceptan cierto riesgo de conclusiones erróneas de cierto tipo (rechazos erróneos de la [[hipótesis nula]]). Este nivel de riesgo se denomina [[Significación estadística|''significación estadística'']]. Cuando se realizan una gran cantidad de pruebas, algunas arrojan resultados falsos de este tipo; por lo tanto, se podría informar (erróneamente) que el 5% de las hipótesis elegidas al azar son estadísticamente significativas al nivel de significancia del 5%, se podría informar (erróneamente) que el 1% es estadísticamente significativa al nivel de significancia del 1%, y así sucesivamente, sólo por casualidad. Cuando se prueban suficientes hipótesis, es prácticamente seguro que algunas serán estadísticamente significativas (aunque esto sea engañoso), ya que casi todos los conjuntos de datos con algún grado de aleatoriedad probablemente contengan (por ejemplo) algunas [[Relación espuria|correlaciones espurias]]. Si no son cautelosos, estos resultados pueden engañar fácilmente a los investigadores que utilizan técnicas de minería de datos. El término ''p-hacking'' (en referencia a [[Valor p|los valores ''p'']] ) fue acuñado en un artículo de 2014 por los tres investigadores detrás del blog [[Data Colada]], que se ha centrado en descubrir este tipo de problemas en la investigación de las ciencias sociales. <ref name=":3">{{Cita web|url=https://www.wsj.com/science/data-colada-debunk-stanford-president-research-14664f3|título=The Band of Debunkers Busting Bad Scientists|fechaacceso=2023-10-08|autor=Subbaraman|nombre=Nidhi|fecha=2023-09-24|sitioweb=[[Wall Street Journal]]|idioma=en-US|urlarchivo=https://archive.today/20230924094046/https://www.wsj.com/science/data-colada-debunk-stanford-president-research-14664f3|fechaarchivo=2023-09-24}}</ref> <ref>{{Cita web|url=https://psycnet.apa.org/record/2013-25331-001|título=APA PsycNet|fechaacceso=2023-10-08|sitioweb=psycnet.apa.org|idioma=en}}</ref> |

||

El dragado de datos es un ejemplo de cómo ignorar el problema de las comparaciones múltiples. Una forma es cuando se comparan subgrupos sin alertar al lector sobre el número total de comparaciones de subgrupos examinadas. <ref name="Deming">{{Cita publicación|url=http://www.niss.org/sites/default/files/Young%20Karr%20Obs%20Study%20Problem.pdf|título=Deming, data and observational studies|apellidos=Young, S. S.|apellidos2=Karr, A.|publicación=Significance|volumen=8|número=3|páginas=116–120|doi=10.1111/j.1740-9713.2011.00506.x|año=2011}} |

El dragado de datos es un ejemplo de cómo ignorar el problema de las comparaciones múltiples. Una forma es cuando se comparan subgrupos sin alertar al lector sobre el número total de comparaciones de subgrupos examinadas. <ref name="Deming">{{Cita publicación|url=http://www.niss.org/sites/default/files/Young%20Karr%20Obs%20Study%20Problem.pdf|título=Deming, data and observational studies|apellidos=Young, S. S.|apellidos2=Karr, A.|publicación=Significance|volumen=8|número=3|páginas=116–120|doi=10.1111/j.1740-9713.2011.00506.x|año=2011}} |

||

| Línea 32: | Línea 32: | ||

=== Modelado múltiple === |

=== Modelado múltiple === |

||

Otro aspecto del condicionamiento de [[Contraste de hipótesis|las pruebas estadísticas]] por el conocimiento de los datos se puede ver al utilizar el system or machine analysis and |

Otro aspecto del condicionamiento de [[Contraste de hipótesis|las pruebas estadísticas]] por el conocimiento de los datos se puede ver al utilizar el system or machine analysis and regresión lineal para observar la frecuencia de los datos. Un paso crucial en el proceso es decidir qué [[Variables dependientes e independientes|covariables]] incluir en una relación que explica una o más variables. Hay consideraciones tanto estadísticas (por ejemplo regresión por pasos) <ref>Efroymson,M. A. (1960) "Multiple regression analysis," Mathematical Methods for Digital Computers, Ralston A. and Wilf,H. S., (eds.), Wiley, New York.</ref>como sustantivas que llevan a los autores a favorecer algunos de sus modelos sobre otros, y hay un uso liberal de pruebas estadísticas. Sin embargo, descartar una o más variables de una relación explicativa sobre la base de los datos significa que no se pueden aplicar válidamente procedimientos estadísticos estándar a las variables retenidas en la relación como si nada hubiera sucedido. Por la naturaleza del caso, las variables retenidas tuvieron que pasar algún tipo de prueba preliminar (posiblemente intuitiva e imprecisa) que las variables descartadas fallaron. En 1966, Selvin y Stuart compararon las variables retenidas en el modelo con los peces que no caen a través de la red, en el sentido de que sus efectos seguramente serán mayores que los de los que caen a través de la red. Esto no sólo altera el desempeño de todas las pruebas posteriores sobre el modelo explicativo retenido, sino que también puede introducir sesgo y alterar el [[error cuadrático medio]] en la estimación. <ref name="Selvin"> |

||

{{Cita publicación|título=Data-Dredging Procedures in Survey Analysis|apellidos=Selvin, H. C.|apellidos2=Stuart, A.|publicación=The American Statistician|volumen=20|número=3|páginas=20–23|doi=10.1080/00031305.1966.10480401|año=1966}} |

{{Cita publicación|título=Data-Dredging Procedures in Survey Analysis|apellidos=Selvin, H. C.|apellidos2=Stuart, A.|publicación=The American Statistician|volumen=20|número=3|páginas=20–23|doi=10.1080/00031305.1966.10480401|año=1966}} |

||

</ref> <ref name="BerkBrownZhao"> |

</ref> <ref name="BerkBrownZhao"> |

||

Revisión del 17:30 13 ene 2024

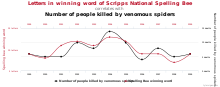

El dragado de datos (también conocido como espionaje de datos o p-hacking) [1] es el uso indebido del análisis de datos para encontrar patrones en los datos que puedan presentarse como estadísticamente significativos, aumentando y subestimando así dramáticamente el riesgo de información falsa positiva. Esto se hace realizando muchas pruebas estadísticas sobre los datos y solo informando aquellas que arrojan resultados significativos. [2]

El proceso de dragado de datos implica probar múltiples hipótesis utilizando un único conjunto de datos mediante una búsqueda de fuerza bruta, tal vez de combinaciones de variables que podrían mostrar una correlación, y tal vez de grupos de casos u observaciones que muestran diferencias en su media o en su desglose por alguna otra variable.

Las pruebas convencionales de significación estadística se basan en la probabilidad de que surja un resultado particular si solo actuara el azar, y necesariamente aceptan cierto riesgo de conclusiones erróneas de cierto tipo (rechazos erróneos de la hipótesis nula). Este nivel de riesgo se denomina significación estadística. Cuando se realizan una gran cantidad de pruebas, algunas arrojan resultados falsos de este tipo; por lo tanto, se podría informar (erróneamente) que el 5% de las hipótesis elegidas al azar son estadísticamente significativas al nivel de significancia del 5%, se podría informar (erróneamente) que el 1% es estadísticamente significativa al nivel de significancia del 1%, y así sucesivamente, sólo por casualidad. Cuando se prueban suficientes hipótesis, es prácticamente seguro que algunas serán estadísticamente significativas (aunque esto sea engañoso), ya que casi todos los conjuntos de datos con algún grado de aleatoriedad probablemente contengan (por ejemplo) algunas correlaciones espurias. Si no son cautelosos, estos resultados pueden engañar fácilmente a los investigadores que utilizan técnicas de minería de datos. El término p-hacking (en referencia a los valores p ) fue acuñado en un artículo de 2014 por los tres investigadores detrás del blog Data Colada, que se ha centrado en descubrir este tipo de problemas en la investigación de las ciencias sociales. [3] [4]

El dragado de datos es un ejemplo de cómo ignorar el problema de las comparaciones múltiples. Una forma es cuando se comparan subgrupos sin alertar al lector sobre el número total de comparaciones de subgrupos examinadas. [5]

Tipos

Sacar conclusiones de los datos

El procedimiento de prueba de hipótesis estadística convencional que utiliza la probabilidad frecuentista consiste en formular una hipótesis de investigación, como "las personas de clases sociales más altas viven más tiempo" y luego recopilar datos relevantes. Por último, se lleva a cabo una prueba de significación estadística para ver qué tan probable es que los resultados sean solo por casualidad (también llamada prueba contra la hipótesis nula).

Un punto clave en un análisis estadístico adecuado es probar una hipótesis con evidencia (datos) que no se utilizó para construir la hipótesis. Esto es fundamental porque cada conjunto de datos contiene algunos patrones que se deben enteramente al azar. Si la hipótesis no se prueba en un conjunto de datos diferente de la misma población estadística, es imposible evaluar la probabilidad de que el azar por sí solo produzca tales patrones.

Por ejemplo, lanzar una moneda cinco veces con un resultado de 2 caras y 3 cruces podría llevar a la hipótesis de que la moneda favorece a las cruces entre 3/5 y 2/5. Si luego se prueba esta hipótesis con el conjunto de datos existente, se confirma, pero la confirmación no tiene sentido. El procedimiento adecuado habría sido formar de antemano una hipótesis sobre cuál es la probabilidad de cruz y luego lanzar la moneda varias veces para ver si la hipótesis se rechaza o no. Si se observan tres cruces y dos caras, se podría formar otra hipótesis, que la probabilidad de cruz es 3/5, pero sólo podría probarse mediante una nueva serie de lanzamientos de moneda. Es importante darse cuenta de que la significancia estadística bajo el procedimiento incorrecto es completamente espuria: las pruebas de significancia no protegen contra el dragado de datos.

Hipótesis sugerida por datos no representativos.

Supongamos que un estudio de una muestra aleatoria de personas incluye exactamente dos personas cuyo cumpleaños es el 7 de agosto: Mary y John. Alguien involucrado en la extracción de datos podría intentar encontrar similitudes adicionales entre María y Juan. Al analizar cientos o miles de posibles similitudes entre los dos, cada una de las cuales tiene una baja probabilidad de ser cierta, es casi seguro que se puede encontrar una similitud inusual. Quizás John y Mary sean las únicas dos personas del estudio que cambiaron de menor tres veces en la universidad. Una hipótesis, sesgada por la extracción de datos, podría ser entonces que "las personas nacidas el 7 de agosto tienen muchas más posibilidades de cambiar de menor más de dos veces en la universidad".

Se podría considerar que los datos mismos, tomados fuera de contexto, respaldan firmemente esa correlación, ya que nadie con una fecha de nacimiento diferente había cambiado de menor tres veces en la universidad. Sin embargo, si (como es probable) se trata de una hipótesis espuria, lo más probable es que este resultado no sea reproducible ; cualquier intento de comprobar si otras personas que cumplen años el 7 de agosto tienen una tasa similar de cambio de menores probablemente obtendrá resultados contradictorios casi de inmediato.

Sesgo sistemático

El sesgo es un error sistemático en el análisis. Por ejemplo, los médicos dirigieron a los pacientes con VIH con alto riesgo cardiovascular a un tratamiento particular contra el VIH, abacavir, y a los pacientes con menor riesgo a otros medicamentos, impidiendo una evaluación simple de abacavir en comparación con otros tratamientos. Un análisis que no corrigió este sesgo penalizó injustamente al abacavir, ya que sus pacientes tenían mayor riesgo y, por lo tanto, más de ellos sufrieron ataques cardíacos. [6] Este problema puede ser muy grave, por ejemplo, en el estudio observacional. [5] [7]

Los factores faltantes, los factores de confusión no medidos y las pérdidas durante el seguimiento también pueden generar sesgos. [5] Al seleccionar artículos con valores p significativos, se seleccionan estudios negativos, lo que constituye un sesgo de publicación. Esto también se conoce como sesgo del cajón de archivos, porque los resultados de valor p menos significativos se dejan en el cajón de archivos y nunca se publican. [8]

Modelado múltiple

Otro aspecto del condicionamiento de las pruebas estadísticas por el conocimiento de los datos se puede ver al utilizar el system or machine analysis and regresión lineal para observar la frecuencia de los datos. Un paso crucial en el proceso es decidir qué covariables incluir en una relación que explica una o más variables. Hay consideraciones tanto estadísticas (por ejemplo regresión por pasos) [9]como sustantivas que llevan a los autores a favorecer algunos de sus modelos sobre otros, y hay un uso liberal de pruebas estadísticas. Sin embargo, descartar una o más variables de una relación explicativa sobre la base de los datos significa que no se pueden aplicar válidamente procedimientos estadísticos estándar a las variables retenidas en la relación como si nada hubiera sucedido. Por la naturaleza del caso, las variables retenidas tuvieron que pasar algún tipo de prueba preliminar (posiblemente intuitiva e imprecisa) que las variables descartadas fallaron. En 1966, Selvin y Stuart compararon las variables retenidas en el modelo con los peces que no caen a través de la red, en el sentido de que sus efectos seguramente serán mayores que los de los que caen a través de la red. Esto no sólo altera el desempeño de todas las pruebas posteriores sobre el modelo explicativo retenido, sino que también puede introducir sesgo y alterar el error cuadrático medio en la estimación. [10] [11]

Ejemplos

En meteorología y epidemiología

En meteorología, las hipótesis a menudo se formulan utilizando datos meteorológicos hasta el presente y se comparan con datos meteorológicos futuros, lo que garantiza que, incluso de forma inconsciente, los datos futuros no puedan influir en la formulación de la hipótesis. Por supuesto, una disciplina así requiere esperar a que lleguen nuevos datos para mostrar el poder predictivo de la teoría formulada frente a la hipótesis nula. Este proceso garantiza que nadie pueda acusar al investigador de adaptar manualmente el modelo predictivo a los datos disponibles, ya que el tiempo que se avecina aún no está disponible.

Como otro ejemplo, supongamos que los observadores notan que una ciudad en particular parece tener un conglomerado de cáncer, pero carecen de una hipótesis firme de por qué es así. Sin embargo, tienen acceso a una gran cantidad de datos demográficos sobre la ciudad y sus alrededores, que contienen mediciones del área de cientos o miles de variables diferentes, en su mayoría no correlacionadas. Incluso si todas estas variables son independientes de la tasa de incidencia del cáncer, es muy probable que al menos una variable se correlacione significativamente con la tasa de cáncer en toda el área. Si bien esto puede sugerir una hipótesis, se necesitan pruebas adicionales utilizando las mismas variables pero con datos de una ubicación diferente para confirmarla. Tenga en cuenta que un valor p de 0,01 sugiere que el 1% de las veces un resultado al menos tan extremo se obtendría por casualidad; Si se prueban cientos o miles de hipótesis (con variables independientes relativamente no correlacionadas entre sí), es probable que se obtenga un valor p inferior a 0,01 para muchas hipótesis nulas.

En sociología

Otra forma de aplanar una curva p es controlar por género. Un análisis de Simonsohn et. Alabama. de un estudio de Bruns e Ioannidis (2016) demuestra esto, ya que cuando Bruns e Ioannidis eliminaron el control de género, esto también redujo el valor t informado de 9,29 a 0,88, lo que muestra un efecto no causal donde previamente se registró uno causal (3). [12] Este es un hallazgo importante porque los valores t son inversamente proporcionales a los valores p, lo que significa que los valores t más altos (por encima de 2,8) indican valores p más bajos. Al controlar por género, se puede inflar artificialmente el valor t, desinflando así artificialmente también el valor p.

Aparición en los medios

Un ejemplo es el estudio engañoso sobre la pérdida de peso con chocolate realizado por el periodista John Bohannon, quien explicó públicamente en un artículo de Gizmodo que el estudio se llevó a cabo deliberadamente de manera fraudulenta como un experimento social. [13] Este estudio se difundió en muchos medios de comunicación alrededor de 2015, y muchas personas creyeron, en contra de su mejor juicio, la afirmación de que comer una barra de chocolate todos los días les haría perder peso. Este estudio fue publicado en el Instituto de Dieta y Salud. Según Bohannon, para reducir el valor p por debajo de 0,05, era crucial tener en cuenta 18 variables diferentes al realizar las pruebas.

Remedios

Si bien buscar patrones en los datos es legítimo, aplicar una prueba estadística de significancia o una prueba de hipótesis a los mismos datos hasta que surja un patrón es propenso a abuso. Una forma de formular hipótesis evitando al mismo tiempo el dragado de datos es realizar pruebas aleatorias fuera de la muestra. El investigador recopila un conjunto de datos y luego lo divide aleatoriamente en dos subconjuntos, A y B. Sólo se examina un subconjunto (digamos, el subconjunto A) para crear hipótesis. Una vez formulada una hipótesis, se debe probar en el subconjunto B, que no se utilizó para construir la hipótesis. Sólo cuando B también apoya dicha hipótesis es razonable creer que la hipótesis podría ser válida. (Este es un tipo simple de validación cruzada y a menudo se denomina prueba de entrenamiento o validación dividida por la mitad).

Otro remedio para el dragado de datos es registrar el número de todas las pruebas de significancia realizadas durante el estudio y simplemente dividir el criterio de significancia (alfa) por este número, esta es la corrección de Bonferroni. Sin embargo, esta es una métrica muy conservadora. Un alfa familiar de 0,05, dividido de esta manera por 1.000 para tener en cuenta 1.000 pruebas de significancia, produce un alfa por hipótesis muy estricto de 0,00005. Los métodos particularmente útiles en el análisis de la varianza y en la construcción de bandas de confianza simultáneas para regresiones que involucran funciones de base son el método de Scheffé y, si el investigador tiene en mente sólo comparaciones por pares, el método de Tukey. Para evitar el extremo conservadurismo de la corrección de Bonferroni, se encuentran disponibles métodos de inferencia selectiva más sofisticados. [14] El método de inferencia selectiva más común es el uso del procedimiento de control de la tasa de descubrimiento falso de Benjamini y Hochberg: es un enfoque menos conservador que se ha convertido en un método popular para el control de pruebas de hipótesis múltiples.

En última instancia, la significancia estadística de una prueba y la confianza estadística de un hallazgo son propiedades conjuntas de los datos y el método utilizado para examinarlos. Así, si alguien dice que un determinado evento tiene una probabilidad del 20% ± 2% 19 de 20 veces, esto significa que si la probabilidad del evento se estima por el mismo método utilizado para obtener la estimación del 20%, el resultado está entre 18% y 22% con probabilidad 0,95. No se puede hacer ninguna afirmación de significación estadística con solo mirar, sin tener en cuenta el método utilizado para evaluar los datos.

Cuando ninguno de los enfoques es práctico, se puede hacer una distinción clara entre análisis de datos que son confirmatorios y análisis que son exploratorios. La inferencia estadística sólo es apropiada para el primero. [11]Las revistas académicas están adoptando cada vez más el formato de informe registrado, cuyo objetivo es contrarrestar problemas muy graves como el dragado de datos y el HARKing, que han hecho que la investigación basada en pruebas teóricas sea muy poco fiable.. Por ejemplo, Nature Human Behavior ha adoptado el formato de informe registrado, ya que "desplaza el énfasis de los resultados de la investigación a las preguntas que guían la investigación y los métodos utilizados para responderlas". [15] El European Journal of Personality define este formato de la siguiente manera: "En un informe registrado, los autores crean una propuesta de estudio que incluye antecedentes teóricos y empíricos, preguntas/hipótesis de investigación y datos piloto (si están disponibles). Una vez enviada, esta propuesta será revisado antes de la recopilación de datos y, si se acepta, el artículo resultante de este procedimiento revisado por pares se publicará, independientemente de los resultados del estudio". [16]

Los métodos y resultados también pueden ponerse a disposición del público, como en el enfoque de ciencia abierta, lo que dificulta aún más la extracción de datos. [17]

Véase también

Referencias

- ↑ Wasserstein, Ronald L.; Lazar, Nicole A. (2 de abril de 2016). «The ASA Statement on p-Values: Context, Process, and Purpose». The American Statistician (Informa UK Limited) 70 (2): 129-133. ISSN 0003-1305. doi:10.1080/00031305.2016.1154108.

- ↑ Davey Smith, G.; Ebrahim, S. (2002). «Data dredging, bias, or confounding». BMJ 325 (7378): 1437-1438. PMC 1124898. PMID 12493654. doi:10.1136/bmj.325.7378.1437.

- ↑ Subbaraman, Nidhi (24 de septiembre de 2023). «The Band of Debunkers Busting Bad Scientists». Wall Street Journal (en inglés estadounidense). Archivado desde el original el 24 de septiembre de 2023. Consultado el 8 de octubre de 2023.

- ↑ «APA PsycNet». psycnet.apa.org (en inglés). Consultado el 8 de octubre de 2023.

- ↑ a b c Young, S. S.; Karr, A. (2011). «Deming, data and observational studies». Significance 8 (3): 116-120. doi:10.1111/j.1740-9713.2011.00506.x.

- ↑ Young, S. S.; Karr, A. (2011). «Deming, data and observational studies». Significance 8 (3): 116-120. doi:10.1111/j.1740-9713.2011.00506.x.

- ↑ Davey Smith, G.; Ebrahim, S. (2002). «Data dredging, bias, or confounding». BMJ 325 (7378): 1437-1438. PMC 1124898. PMID 12493654. doi:10.1136/bmj.325.7378.1437.

- ↑ «The File Drawer Problem (Publication Bias)». Consultado el 1 de diciembre de 2023.

- ↑ Efroymson,M. A. (1960) "Multiple regression analysis," Mathematical Methods for Digital Computers, Ralston A. and Wilf,H. S., (eds.), Wiley, New York.

- ↑ Selvin, H. C.; Stuart, A. (1966). «Data-Dredging Procedures in Survey Analysis». The American Statistician 20 (3): 20-23. doi:10.1080/00031305.1966.10480401.

- ↑ a b Berk, R.; Brown, L.; Zhao, L. (2009). «Statistical Inference After Model Selection». J Quant Criminol 26 (2): 217-236. doi:10.1007/s10940-009-9077-7.

- ↑ Simonsohn, Uri; Nelson, Leif D.; Simmons, Joseph P. (11 de marzo de 2019). «P-curve won't do your laundry, but it will distinguish replicable from non-replicable findings in observational research: Comment on Bruns & Ioannidis (2016).». PLOS ONE 14 (3): e0213454. Bibcode:2019PLoSO..1413454S. PMC 6411107. PMID 30856227. doi:10.1371/journal.pone.0213454.

- ↑ Bohannon, John (27 de mayo de 2015). «I Fooled Millions Into Thinking Chocolate Helps Weight Loss. Here's How.». Gizmodo (en inglés). Consultado el 20 de octubre de 2023.

- ↑ Taylor, J.; Tibshirani, R. (2015). «Statistical learning and selective inference». Proceedings of the National Academy of Sciences 112 (25): 7629-7634. doi:10.1073/pnas.1507583112.

- ↑ «Promoting reproducibility with registered reports». Nature Human Behaviour 1 (1): 0034. 10 January 2017. doi:10.1038/s41562-016-0034.

- ↑ «Streamlined review and registered reports soon to be official at EJP». ejp-blog.com. 6 February 2018.

- ↑ Vyse, Stuart (2017). «P-Hacker Confessions: Daryl Bem and Me». Skeptical Inquirer 41 (5): 25-27. Archivado desde el original el 5 de agosto de 2018. Consultado el 5 August 2018.

- ↑ «Garden of forking paths». FORRT - Framework for Open and Reproducible Research Training (en inglés estadounidense). Consultado el 28 de julio de 2023.

- ↑ Gelman, Andrew; Loken, Eric (November 14, 2013). «The garden of forking paths: Why multiple comparisons can be a problem, even when there is no "fishing expedition" or "p-hacking" and the research hypothesis was posited ahead of time».

- ↑ «Princeton Multi-Voxel Pattern Analysis (MVPA) Toolbox | Neuroscience». pni.princeton.edu. Consultado el 23 de julio de 2019.

- ↑ Kerr, N. L. (1998). «HARKing: Hypothesizing after the results are known.». Personality and Social Psychology Review 2 (3): 196-217. PMID 15647155. doi:10.1207/s15327957pspr0203_4. Parámetro desconocido

|doi-access=ignorado (ayuda) - ↑ «Synopsis: Controlling for the "look-elsewhere effect"». American Physical Society. 2011.

- ↑ Lori Ann White (August 12, 2011). «Word of the Week: Look Elsewhere Effect». Stanford National Accelerator Laboratory. Archivado desde el original el April 19, 2012. Parámetro desconocido

|url-status=ignorado (ayuda) - ↑ Gardenier, John; Resnik, David (2002). «The misuse of statistics: concepts, tools, and a research agenda». Accountability in Research: Policies and Quality Assurance 9 (2): 65-74. PMID 12625352. S2CID 24167609. doi:10.1080/08989620212968.

- ↑ «What is the significance and use of post-hoc analysis studies?». www.cwauthors.com. Consultado el 9 de diciembre de 2022.

Otras lecturas

- Ioannidis, John P.A. (August 30, 2005). «Why Most Published Research Findings Are False». PLOS Medicine (San Francisco: Public Library of Science) 2 (8): e124. ISSN 1549-1277. PMC 1182327. PMID 16060722. doi:10.1371/journal.pmed.0020124.

- Head, Megan L.; Holman, Luke; Lanfear, Rob; Kahn, Andrew T.; Jennions, Michael D. (13 March 2015). «The Extent and Consequences of P-Hacking in Science». PLOS Biology 13 (3): e1002106. PMC 4359000. PMID 25768323. doi:10.1371/journal.pbio.1002106.

- Insel, Thomas (November 14, 2014). «P-Hacking». NIMH Director's Blog (en inglés).

- Smith, Gary (2016). Standard Deviations: Flawed Assumptions, Tortured Data, and Other Ways to Lie with Statistics. Gerald Duckworth & Co. ISBN 9780715649749.

Enlaces externos

- Una bibliografía sobre el sesgo de espionaje de datos

- Correlaciones espurias, una galería de ejemplos de correlaciones inverosímiles

- StatQuest: P-value pitfalls and power calculations en YouTube.

- Video que explica el p-hacking de " Neuroskeptic ", un blogger de la revista Discover

- Step Away From Stepwise, un artículo del Journal of Big Data que critica la regresión gradual