Pruebas unilaterales y bilaterales

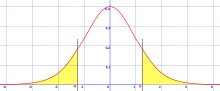

En las pruebas de significación estadística, las pruebas de una cola y las pruebas de dos colas, también llamadas pruebas unilaterales y bilaterales respectivamente, son formas alternativas de calcular la significación estadística de un parámetro inferido de un conjunto de datos en el contexto de una prueba estadística. Una prueba bilateral es apropiada si el valor estimado es mayor o menor que un determinado intervalo de valores, por ejemplo, si un examinado puede puntuar por encima o por debajo de un intervalo específico de puntuaciones. Este método se utiliza para comprobar la hipótesis nula y, si el valor estimado existe en las áreas críticas, se acepta la hipótesis alternativa frente a la nula. Una prueba de una cola es adecuada si el valor estimado puede desviarse del valor de referencia sólo en una dirección, a la izquierda o a la derecha, pero no en ambas. Un ejemplo puede ser si una máquina produce más de un uno por ciento de productos defectuosos. En este caso, si el valor estimado se encuentra en una de las zonas críticas unilaterales, en función de la dirección de interés (mayor que o menor que), se acepta la hipótesis alternativa frente a la nula. Los nombres alternativos son pruebas unilaterales y bilaterales; la terminología "cola" se usa porque las partes extremas de las distribuciones, donde las observaciones conducen al rechazo de la hipótesis nula, son pequeñas y, a menudo, disminuyen hacia cero como en la distribución normal, coloreadas en amarillo, o crean una "curva de campana", lo cual es representado a la derecha en color verde.

Aplicaciones[editar]

Las pruebas de una cola se utilizan para distribuciones asimétricas que tienen una sola cola, como la distribución ji al cuadrado, las cuales son comunes para medir la bondad de ajuste, o para un solo lado de una distribución que tiene dos colas, como la distribución normal, habitual en la estimación de la localización; esto corresponde a especificar una dirección. Las pruebas de dos colas solo son aplicables cuando hay dos colas, como en la distribución normal, e implican el considerar significativa cualquiera de las dos direcciones.[1][2]

De acuerdo con el enfoque de Ronald Fisher, la hipótesis nula H 0 se rechaza cuando el valor p de la prueba estadística es un resultado bastante extremo (en relación con la distribución muestral de la prueba estadística), por lo que, en consecuencia, se considera improbable que sea resultado de la aleatoriedad. Esto suele hacerse comparando el valor p resultante con el nivel de significación especificado, denotado por , al calcular la significación estadística de un parámetro. En una prueba de una cola, se decide de antemano si "extremo" significa únicamente "suficientemente pequeño" o "suficientemente grande"; mientras que los valores en la otra dirección se consideran no significativos. Se tiene la libertad de escoger la probabilidad de la cola izquierda o la de la derecha como el valor p unilateral, que en última instancia corresponde a la dirección en la que la prueba estadística se desvía de H0. [3] En una prueba de dos colas, "extremo" significa "ya sea suficientemente pequeño o suficientemente grande", y los valores en cualquier dirección se consideran significativos. Para una determinada prueba estadística, se realiza una sola prueba de dos colas y dos pruebas de una cola, una por cada dirección. Cuando se proporciona un nivel de significación , las regiones críticas existirían en los dos extremos de la cola de la distribución con un área de cada uno para una prueba de dos colas. Alternativamente, la región crítica existiría únicamente en el extremo de una cola con un área de para una prueba unilateral. Para un nivel de significación dado en una prueba de dos colas para una prueba estadística, las pruebas unilaterales correspondientes para la misma prueba estadística tendrán el doble de significación (la mitad del valor p) si los datos están en la dirección especificada por la prueba, o ninguna significación (valor p superior a 𝛼) si los datos están en la dirección opuesta a la región crítica especificada por la prueba.

Ejemplo de lanzamiento de moneda[editar]

En el lanzamiento de monedas, la hipótesis nula es una secuencia de ensayos Bernoulli con probabilidad 0,5, que produce una variable aleatoria X que es 1 para cara y 0 para cruz, y un estadístico de prueba común es la media muestral (del número de caras) Si se comprueba que la moneda tiene tendencia a salir cara, se utilizaría una prueba de una cola: sólo un gran número de caras sería significativo. En ese caso, un conjunto de datos de cinco cabezas (HHHHH), con media muestral de 1, tiene una posibilidad de que ocurra, (5 lanzamientos consecutivos con 2 resultados - ((1/2)^5 =1/32). esto tendría y sería significativa (rechazando la hipótesis nula) si la prueba se analizara a un nivel de significación de (el nivel de significación correspondiente al límite de corte). in embargo, si se comprueba si la moneda tiene sesgo hacia cara o cruz, se utilizaría una prueba de dos colas, y un conjunto de datos de cinco caras (media muestral 1) es tan extremo como un conjunto de datos de cinco colas (media muestral 0). Como resultado, el valor p sería y esto no sería significativo (no rechazando la hipótesis nula) si la prueba se analizara a un nivel de significación de .

El valor p fue introducido por Karl Pearson[4] en la prueba chi-cuadrado de Pearson, donde definió P (notación original) como la probabilidad de que la estadística se sitúe en o por encima de un nivel determinado. Se trata de una definición de una cola, y la distribución chi-cuadrado es asimétrica, sólo asume valores positivos o cero, y sólo tiene una cola, la superior. Mide la bondad del ajuste de los datos con una distribución teórica, correspondiendo el cero a la concordancia exacta con la distribución teórica; el valor p mide, por tanto, la probabilidad de que el ajuste sea así de malo o peor.

La distinción entre pruebas de una cola y de dos colas fue popularizada por Ronald Fisher en el influyente libro Statistical Methods for Research Workers,[5] donde la aplicó especialmente a la distribución normal, que es una distribución simétrica con dos colas iguales. La distribución normal es una medida común de la localización, en lugar de la bondad de ajuste, y tiene dos colas, que corresponden a que la estimación de la localización está por encima o por debajo de la localización teórica (por ejemplo, la media de la muestra comparada con la media teórica). En el caso de una distribución simétrica como la normal, el valor p de una cola es exactamente la mitad del valor p de dos colas:[5]

Some confusion is sometimes introduced by the fact that in some cases we wish to know the probability that the deviation, known to be positive, shall exceed an observed value, whereas in other cases the probability required is that a deviation, which is equally frequently positive and negative, shall exceed an observed value; the latter probability is always half the former.

Fisher hizo hincapié en la importancia de medir la cola -el valor observado de la estadística de prueba y todos los más extremos- en lugar de simplemente la probabilidad del resultado específico en sí, en su obra Diseño de experimentos (1935).[6] Lo explica así porque un conjunto específico de datos puede ser improbable (en la hipótesis nula), pero resultados más extremos probables, por lo que, visto así, los datos específicos pero no extremos improbables no deberían considerarse significativos.

Pruebas específicas[editar]

Si el estadístico de la prueba sigue una distribución t de Student en la hipótesis nula, lo que es habitual cuando la variable subyacente sigue una distribución normal con un factor de escala desconocido, la prueba se denomina prueba t de una o dos colas. Si la prueba se realiza utilizando la media y la varianza reales de la población, en lugar de una estimación a partir de una muestra, se denominaría prueba Z de una o dos colas.

Las tablas estadísticas para t y para Z proporcionan valores críticos tanto para pruebas de una cola como de dos colas. Es decir, proporcionan los valores críticos que cortan una región entera en uno u otro extremo de la distribución muestral, así como los valores críticos que cortan las regiones (de la mitad de tamaño) en ambos extremos de la distribución muestral.

Véase también[editar]

- Prueba de diferencia pareada, cuando se comparan dos muestras

Referencias[editar]

- ↑ Mundry, R.; Fischer, J. (1998). «Use of Statistical Programs for Nonparametric Tests of Small Samples Often Leads to Incorrect P Values: Examples from Animal Behaviour». Animal Behaviour 56 (1): 256-259. PMID 9710485. doi:10.1006/anbe.1998.0756.

- ↑ Pillemer, D. B. (1991). «One-versus two-tailed hypothesis tests in contemporary educational research». Educational Researcher 20 (9): 13-17. doi:10.3102/0013189X020009013.

- ↑ A modern introduction to probability and statistics : understanding why and how. Dekking, Michel, 1946-. London: Springer. 2005. pp. 389–390. ISBN 9781852338961. OCLC 262680588.

- ↑ Pearson, Karl (1900). «On the criterion that a given system of deviations from the probable in the case of a correlated system of variables is such that it can be reasonably supposed to have arisen from random sampling». Philosophical Magazine. Series 5 50 (302): 157-175. doi:10.1080/14786440009463897.

- ↑ a b Fisher, Ronald (1925). Statistical Methods for Research Workers. Edinburgh: Oliver & Boyd. ISBN 0-05-002170-2.

- ↑ Fisher, Ronald A. (1971). The Design of Experiments (9th edición). Macmillan. ISBN 0-02-844690-9.