Intervalo de predicción

En estadística inferencial, específicamente en inferencia predictiva, un intervalo de predicción es una estimación de un intervalo de valores en el que se producirá una observación futura con determinada probabilidad, dado lo que ya se ha observado. Los intervalos de predicción se utilizan a menudo en análisis de la regresión.

Se utilizan tanto en estadística frecuentista como en estadística bayesiana: un intervalo de predicción guarda la misma relación con una observación futura que un intervalo de confianza frecuentista o intervalo de credibilidad bayesiano muestran con relación a un parámetro de población no observable: los intervalos de predicción estiman la distribución de futuros sucesos individuales según su valor, mientras que los intervalos de confianza y de credibilidad predicen la distribución de la media real de la población u otra cantidad de interés que no puede ser observada directamente (por ejemplo, cuando solo se poseen muestras de poblaciones muy grandes).

Introducción

[editar]Por ejemplo, si se hace la suposición paramétrica de que la distribución subyacente de un determinado fenómeno observable es una distribución normal, y se dispone de un conjunto de muestras {X1, ..., Xn}, entonces los intervalos de confianza y credibilidad se pueden usar para estimar la media μ y la desviación típica σ de la población subyacente, mientras que los intervalos de predicción se pueden usar para estimar el valor de la siguiente variable de la muestra, Xn+1.

Alternativamente, en términos Bayesianos, un intervalo de predicción se puede describir como un intervalo de credibilidad para una variable por sí misma, en lugar de servir para estimar un parámetro de la distribución de la variable.

El concepto de intervalos de predicción no debe estar restringido a la inferencia sobre un determimado valor futuro de una muestra, sino que puede extenderse a casos más complicados. Por ejemplo, en el contexto de las inundaciones fluviales (donde los análisis a menudo se basan en los valores del mayor caudal de cada año), puede haber interés en hacer inferencias sobre la mayor inundación que probablemente se experimentará en los próximos 50 años.

Dado que los intervalos de predicción solo se refieren a observaciones pasadas y futuras, en lugar de a parámetros de población no observables, algunos estadísticos los recomiendan como un método mejor que los intervalos de confianza, como Seymour Geisser, siguiendo el enfoque sobre observables de Bruno de Finetti.[1]

Distribución normal

[editar]Dada una muestra con distribución normal, cuyos parámetros son desconocidos, es posible dar intervalos de predicción en el sentido frecuentista, es decir, determinar un intervalo [a, b] basado en estadísticas de la muestra mediante experimentos repetidos u observaciones, de forma que el evento Xn+1 se situará en el citado intervalo durante un determinado porcentaje del número de veces que se observe; recibiendo el nombre de "intervalos de confianza predictivos".[2]

Una técnica general de los intervalos de predicción frecuentista es encontrar y calcular una cantidad pivote de los observables X1, ..., Xn, Xn+1 (lo que significa que se establece una función para deducir el comportamiento de los sucesos observables y sus parámetros, y cuya distribución de probabilidad no depende de unos parámetros preestablecidos), que pueden invertirse para dar una probabilidad de que la observación futura Xn+1 caiga en algún intervalo calculado en función de los valores observados hasta el momento, . Cuando se trabaja con una cantidad pivote, dependiendo solo de los observables, su estudio se denomina estadística auxiliar.[3] El método usual para construir cantidades pivote es tomar la diferencia de dos variables que dependan de su ubicación, para que esa ubicación se cancele, y luego tomar la proporción de dos variables que dependan de la escala, haciendo que la relación de escala también se cancele.

La cantidad pivotal más familiar es la t de Student, que puede deducirse mediante este método y se utiliza en el apartado siguiente.

Media conocida, varianza conocida

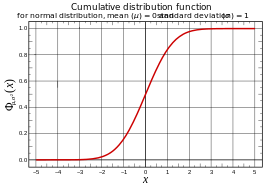

[editar]Un intervalo de predicción [ℓ, u] para una observación futura X en una distribución normal N (µ, σ2) con media y varianza conocidas se pueden calcular a partir de

donde , la unidad tipificada de X, se distribuye como estándar normal.

Por lo tanto

o

siendo z el cuantil en la distribución normal estándar para el cual:

o equivalentemente;

| Intervalo de Predicción |

z |

|---|---|

| 75% | 1.15[4] |

| 90% | 1.64[4] |

| 95% | 1.96[4] |

| 99% | 2.58[4] |

El intervalo de predicción se escribe convencionalmente como:

Por ejemplo, para calcular el intervalo de predicción con una probabilidad del 95% para una distribución normal con una media (µ) de 5 y una desviación estándar (σ) de 1, entonces z es aproximadamente 2 (véase la tabla adjunta). Por lo tanto, el límite inferior del intervalo de predicción es aproximadamente 5 - (2·1) = 3, y el límite superior es aproximadamente 5 + (2·1) = 7, dando así un intervalo de predicción de aproximadamente [3 , 7].

Estimación de los parámetros

[editar]Para una distribución con parámetros desconocidos, un enfoque directo de la predicción es estimar los parámetros y luego usar la función de cuantil asociada; por ejemplo, se puede usar la media de la muestra como estimación para μ y la varianza 's' '2 como una estimación para' 'σ2. Tenga en cuenta que hay dos opciones naturales para s2 aquí: dividir por produce una estimación imparcial, mientras que dividir por n produce el máxima verosimilitud, y cualquiera de ellas puede ser utilizada. Luego se usa la función de cuantiles con estos parámetros estimados para dar un intervalo de predicción.

Este enfoque es utilizable, pero el intervalo resultante no tendrá la interpretación de muestreo repetida,[5] no es un intervalo de confianza predictivo.

Para la secuela, usa la media de la muestra:

y la varianza de la muestra (imparcial):

Media desconocida, varianza conocida

[editar]Dada[6] es una distribución normal con una media desconocida μ pero varianza conocida 1, la media de la muestra de las observaciones tiene una distribución mientras que la futura observación tiene una distribución Tomando la diferencia de estos valores se cancelan la μ y se obtiene una distribución normal de varianza por lo tanto

La resolución de da la distribución de predicción a partir de la cual se pueden calcular intervalos como antes. Este es un intervalo de confianza predictivo en el sentido de que si se usa un rango de cuantiles de 100p%, luego, en las aplicaciones repetidas de este cálculo, la futura observación caerá en el intervalo predicho 100p% de las veces.

Téngase en cuenta que esta distribución de predicción es más conservadora que el uso de la media estimada y la varianza conocida 1, ya que utiliza la varianza , por lo que produce intervalos más amplios. Esto es necesario para que la propiedad del intervalo de confianza deseado se mantenga.

Media conocida, varianza desconocida

[editar]Por el contrario, dada una distribución normal con media conocida 0, pero varianza desconocida , la varianza muestral de las observaciones tiene, prescindiendo de la escala, una distribución ; más precisamente:

mientras que la futura observación tiene distribución Al tomar la proporción de la observación futura y la desviación estándar de la muestra, se cancela el σ, lo que produce una distribución t de Student con n - 1 grados de libertad:

La resolución de da la distribución de predicción a partir de la que se pueden calcular intervalos como antes.

Téngase en cuenta que esta distribución de predicción es más conservadora que el uso de una distribución normal con la desviación estándar estimada y la media conocida 0, ya que utiliza la distribución t en lugar de la distribución normal, por lo que produce intervalos más amplios. Esto es necesario para que la propiedad del intervalo de confianza deseado se mantenga.

Media desconocida, varianza desconocida

[editar]Combinando lo anterior para una distribución normal con μ y σ2 desconocidas se obtiene la siguiente estadística auxiliar:[7]

Esta combinación simple es posible porque la media muestral y la varianza muestral de la distribución normal son estadísticas independientes; esto solo es cierto para la distribución normal y, de hecho, caracteriza la distribución normal.

Resolviendo para se obtiene la distribución de predicción:

La probabilidad de que caiga en un intervalo dado es entonces:

donde Ta es el 100(1 - p/2)ésimo percentil de la distribución t de Student, con n & minus; 1 grados de libertad. Por lo tanto, los números:

son los puntos finales de un intervalo de predicción de 100(1 - p) para .

Métodos no paramétricos

[editar]Se pueden calcular intervalos de predicción sin ningún supuesto sobre la población. Formalmente, este es un método no paramétrico.[8]

Supóngase que se extrae al azar una muestra de dos observaciones X1 y X2 de una población en la que se supone que los valores tienen una distribución de probabilidad continua.

- ¿Cuál es la probabilidad de que X2 > X1?

La respuesta es exactamente el 50%, independientemente de la población subyacente: la probabilidad de elegir 3 y luego 7 es la misma que la de seleccionar 7 y luego 3, independientemente de la probabilidad particular de elegir 3 o 7. Por lo tanto, si se elige un solo punto de muestra X1, entonces el 50% de las veces el siguiente punto de la muestra será mayor, lo que arroja (X1, +∞) como un intervalo de predicción del 50% para X2. De manera similar, el 50% de las veces será más pequeño, lo que produce otro intervalo de predicción del 50% para X2, a saber (−∞, X1). Téngase en cuenta que el supuesto de una distribución continua evita la posibilidad de que los valores puedan ser exactamente iguales; lo que complicaría las cosas.

De manera similar, si se tiene una muestra {X1, ..., Xn}, entonces la probabilidad de que la siguiente observación Xn+1 sea la más grande es de 1/(n + 1), ya que todas las observaciones tienen la misma probabilidad de ser el máximo. De la misma manera, la probabilidad de que Xn+1 sea el valor más pequeño es 1/(n + 1). El otro (n − 1)/(n + 1) de las veces, Xn+1 cae entre el máximo y el mínimo de la muestra {X1, ..., Xn}. Por lo tanto, al anotar el máximo y el mínimo de la muestra como M y m, esto produce un (n − 1)/(n + 1) intervalo de predicción de [m, M].

Por ejemplo, si n = 19, entonces [m, M] da un intervalo de predicción del 18/20= 90%, es decir, que el 90% de las veces, la vigésima observación debería caer entre la observación más pequeña y la más grande observada hasta el momento. Del mismo modo, n = 39 proporciona un intervalo de predicción del 95%, y n = 199 proporciona un intervalo de predicción del 99%.

Más generalmente, si X(j) y X(k) son observaciones ordenadas de la muestra con j < k y j + k = n + 1, entonces [X(j), X(k)] es un intervalo de predicción para Xn+1 con una cobertura de probabilidad (significación estadística) igual a (n + 1 − 2j) / (n + 1).

Este hecho se puede visualizar dibujando los n puntos de la muestra sobre una recta, que divide la línea en n + 1 secciones (n − 1 segmentos entre muestras, y 2 intervalos que van hasta el infinito en ambos extremos), y observando que Xn+1 tiene la misma posibilidad de caer en cualquiera de estas n + 1 secciones. Por lo tanto, también se puede elegir cualquier k de estas secciones y dar un k / (n + 1) intervalo de predicción (o conjunto, si las secciones no son consecutivas). Por ejemplo, si n = 2, entonces la probabilidad de que X3 caiga entre las dos observaciones previas es de 1/3.

Téngase en cuenta que si bien esto da la probabilidad de que una observación futura se encuentre dentro de un rango, no proporciona ninguna estimación de dónde caerá en un segmento, especialmente si se encuentra fuera del rango de valores observados, puede quedar muy lejos del rango. Véase la teoría de valores extremos para un análisis más detallado. Formalmente, esto se aplica no solo al muestreo de una población, sino a cualquier conjunto de variables aleatorias intercambiables, no necesariamente independiente o idénticamente distribuidas.

Contrastar con otros intervalos

[editar]Contraste con intervalos de confianza

[editar]Teniendo en cuenta que en la fórmula para el intervalo de confianza predictivo no se hace mención de los parámetros no observables μ y σ de la media y de la desviación estándar de la población, es posible utilizar las estadísticas obtenidas de las muestras tomadas (su media y su desviación estándar ) para estimar el resultado de muestras "futuras".

En lugar de utilizar estadísticas de muestra como estimadores de parámetros de población y aplicar intervalos de confianza a estas estimaciones, se considera que "la siguiente muestra" es una nueva estadística, y se calcula su distribución muestral.

Mediante los intervalos de confianza obtenidos para los parámetros muestrales, se pueden estimar los parámetros de la población; si se desea interpretar esto como una predicción de la siguiente muestra, se modela "la siguiente muestra" como un sorteo de esta población estimada, utilizando la distribución de "población" (estimada). Por el contrario, en intervalos de confianza predictivos, se usa la distribución de "muestreo" de una muestra de n o n + 1 observaciones de dicha población, y la distribución de la población no se usa directamente, aunque la suposición sobre su forma (aunque no los valores de sus parámetros) se usa para calcular la distribución muestral.

Contraste con los intervalos de tolerancia

[editar]Un intervalo de tolerancia permite establecer con un determinado nivel de confianza la proporción específica de una muestra de una población que se sitúa en su interior, población caracterizada a su vez mediante mediante muestreo.[9]

Aplicaciones

[editar]Los intervalos de predicción se usan comúnmente como definiciones de rangos de referencia, como los utilizados en lls exámenes de sangre comunes para dar una idea de si un examen de sangre es normal o no. Para este propósito, el intervalo de predicción más utilizado es el intervalo de predicción del 95%, y un rango de referencia basado en este puede llamarse "rango de referencia estándar".

Análisis de regresión

[editar]Una aplicación común de los intervalos de predicción es el análisis de la regresión.

Supóngase que los datos están siendo modelados mediante una regresión lineal:

donde es el variable dependiente, es la variable independiente, εi es un término de error aleatorio, y y son parámetros.

Dadas las estimaciones y para los parámetros, como de una regresión lineal simple, el valor resultado previsto yd para un valor dado xd es

(el punto en la línea de regresión), mientras que la respuesta real sería

El punto estimado se llama respuesta media, y es una estimación de la esperanza matemática de yd, es decir,

En cambio, un intervalo de predicción proporciona un intervalo en el que se espera que caiga yd; esto no es necesario si los parámetros reales α y β son conocidos (junto con el término de error εi), pero si se está estimando desde una muestra, entonces puede usarse el error estándar de las estimaciones de la intersección y la pendiente ( y ), así como su correlación, para calcular un intervalo de predicción.

En regresión,Faraway (2002, p. 39) hace una distinción entre los intervalos para las predicciones de la respuesta media, frente a las predicciones de la respuesta observada, que afectan esencialmente a la inclusión o no del sumando unidad dentro de la raíz cuadrada en los factores de expansión anteriores (para más detalles, véase Faraway (2002)).

Estadísticas bayesianas

[editar]Seymour Geisser, un defensor de la inferencia predictiva, proporciona aplicaciones predictivas de estadística bayesiana.[10]

En las estadísticas bayesianas, se pueden calcular intervalos de predicción (bayesianos) a partir de la probabilidad a posteriori de una variable aleatoria, con la forma de un intervalo de credibilidad. En el trabajo teórico, los intervalos de credibilidad a menudo no se calculan para la predicción de eventos futuros, sino para la inferencia de parámetros, es decir, son intervalos de credibilidad de un parámetro, y no sirven para obtener el valor de la variable en sí. Sin embargo, particularmente cuando las aplicaciones se refieren a posibles valores extremos de casos aún no observados, los intervalos de credibilidad para tales valores pueden ser de importancia práctica.

Véase también

[editar]Referencias

[editar]- ↑ James S. Hodges, Published by: Institute of Mathematical Statistics. «Uncertainty, Policy Analysis and Statistics]: Rejoinder». Statistical Science (en inglés). Vol. 2, No. 3 (Aug., 1987), pp. 288-291. Consultado el 12 de junio de 2019.

- ↑ Geisser (1993, p. 6) Chapter 2: Non-Bayesian predictive approaches

- ↑ Geisser (1993, p. 7) Confidence Regions

- ↑ a b c d Tabla A2 en Sterne y Kirkwood (2003, p. 472)

- ↑ Geisser (1993, p. 8-9)

- ↑ Geisser (1993, p. 7) Non-Bayesian Predictive Approaches

- ↑ Geisser (1993, Ejemplo 2.2, p. 9–10) Confidence Regions

- ↑ "Prediction Intervals Archivado el 18 de mayo de 2019 en Wayback Machine.", Statistics @ SUNY Oswego

- ↑ D. S. Young (2010), Book Reviews: "Statistical Tolerance Regions: Theory, Applications, and Computation", TECHNOMETRICS, FEBRUARY 2010, VOL. 52, NO. 1, pp.143-144.

- ↑ Geisser (1993)

Bibliografía

[editar]- Faraway, Julian J. (2002), Practical Regression and Anova using R.

- Geisser, Seymour (1993), Predictive Inference, CRC Press.

- Sterne, Jonathan; Kirkwood, Betty R. (2003), Essential Medical Statistics, Blackwell Science, ISBN 0-86542-871-9.

Lecturas relacionadas

[editar]- Chatfield, C. (1993). «Calculating Interval Forecasts». Journal of Business & Economic Statistics 11 (2): 121-135. doi:10.2307/1391361.

- Lawless, J. F.; Fredette, M. (2005). «Frequentist prediction intervals and predictive distributions». Biometrika 92 (3): 529-542. doi:10.1093/biomet/92.3.529.

- Meade, N.; Islam, T. (1995). «Prediction Intervals for Growth Curve Forecasts». Journal of Forecasting 14 (5): 413-430. doi:10.1002/for.3980140502.

- ISO 16269-8 Interpretación estándar de los datos, Parte 8, Determinación de los intervalos de predicción

![{\displaystyle \left[\mu -z\sigma ,\ \mu +z\sigma \right].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d5f89a81a30c52d1d9e81b768e58fb7841296e73)