Modelo autorregresivo

En estadística y procesamiento de señales, un modelo autorregresivo (AR) es una representación de un proceso aleatorio, en el que la variable de interés depende de sus observaciones pasadas. Específicamente, la variable de interés o de salida, depende linealmente de sus valores anteriores. Por esto decimos que existe dependencia lineal entre las distintas observaciones de la variable.

Una forma de entender un modelo autorregresivo es un proceso que luego de enfrentado a una perturbación tarda tiempo en regresar a su equilibrio de largo plazo. Suponga que nuestra variable de interés es la producción de trigo (en miles de toneladas) en una región. En cada año, la producción de trigo dependerá de las condiciones del suelo, la tecnología agrícola disponible y las condiciones climáticas. Nótese que entre un año y el siguiente, las condiciones del suelo y la tecnología agrícola pueden no cambiar (o hacerlo de forma muy lenta) como para dramáticamente afectar la producción de trigo. Las condiciones climáticas, sin embargo, pueden cambiar dramáticamente de un año a otro. Podríamos argumentar que, en la mayoría de los años (en promedio) las condiciones climáticas son buenas. Pero hay años en los que una sequía se produce. Decimos que esa sequía es una perturbación: aleja nuestra variable (la producción de trigo) de su equilibrio de largo plazo (equilibrio en el que las condiciones climáticas son buenas en promedio). Como la tecnología agrícola y las condiciones del suelo cambian lentamente entre un año y otro, la producción de trigo en cualquier año determinado estará parcialmente influida por la producción en el año anterior. La otra influencia en la producción de trigo estará dada por las perturbaciones, el clima.

El modelo autorregresivo se trata de un caso especial del más general modelo ARMA de series de tiempo.

Definición

La notación AR(p) presenta un modelo autorregresivo de orden p. El modelo AR(p) se define como:

donde son los parámetros del modelo, es una constante, y es Ruido blanco. Esto se puede escribir de manera equivalente usando el operador de retroceso B como

de manera que, moviendo el término sumatorio hacia el lado izquierdo y el uso de la notación polinómica, tenemos

Un modelo autorregresivo por lo tanto se puede ver como la salida de un todo- polo de impulso respuesta infinito filtro cuya entrada es ruido blanco.

Algunas limitaciones son necesarios en los valores de los parámetros de este modelo con el fin de que el modelo se mantiene estacionario en sentido amplio . Por ejemplo, los procesos AR(1) con el modelo |φ1| ≥ 1 no son estacionarias. Generalizando, para que un modelo AR(p) sea estacionario en sentido amplio, las raíces del polinomio \ debe estar dentro del círculo unitario, es decir, cada raíz debe satisfacer .

Efecto intertemporal de los choques

En un proceso AR, un choque de una sola vez afecta a los valores de la variable evolución infinitamente lejos en el futuro. Por ejemplo, considere el AR(1) . Un valor distinto de cero para en el momento t = 1, afecta por la cantidad . Dado que la ecuación para AR es recursiva, se encuentra en términos de , haciendo que el fenómeno citado con anterioridad afecta a por la cantidad . A continuación, por la ecuación, esta en términos de , lo que afecta por ende a por la cantidad . Continuando este proceso, se muestra que el efecto de nunca termina. Si el proceso es estacionario, entonces el efecto disminuye hacia cero en el límite.

Debido a que cada choque afecta a los valores de X infinitamente lejos en el futuro desde el momento en que se producen, cualquier valor dado Xt es afectado por perturbaciones que ocurren infinitamente lejos en el pasado. Esto también se puede ver mediante la reescritura de la autorregresión

Donde el término constante ha sido suprimida por el supuesto de que la variable se ha medido como desviaciones de su media

Cuando la división polinómica en el lado derecho se lleva a cabo, el polinomio en el operador aplica a , o sea, un número infinito de valores rezagados de un infinito de orden que aparecerá en el lado derecho de la ecuación.

Ecuación polinómica característica

La función de autocorrelación de un proceso AR(p) se puede expresar como

donde son las raíces del polinomio

donde B es el operador de backshift , donde es la función que define la autorregresión, y donde son los coeficientes de la autorregresión.

La función de autocorrelación de un proceso AR(p) es una suma de exponenciales en descomposición.

Cada raíz real contribuye un componente de la función de autocorrelación que decae exponencialmente. Del mismo modo, cada par de raíces complejas conjugadas contribuye una oscilación amortiguada exponencialmente.

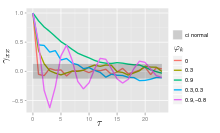

Los gráficos de los procesos AR(p)

El proceso AR simple es AR(0), que no tiene dependencia entre los términos. Sólo el término de error / innovación / ruido contribuye a la salida del proceso, por lo que en la figura, AR (0) corresponde al ruido blanco.

Por un proceso AR(1) con un resultado positivo , sólo el término anterior en el proceso y el término de ruido contribuyen a la salida. Si está cerca de 0, entonces el proceso todavía se ve como ruido blanco, pero como se aproxima a 1, la salida se pone una mayor contribución de la anterior legislatura en relación con el ruido. Esto resulta en una "suavizado" o integración de la salida, similar a un filtro de paso bajo.

Para un proceso AR(2), los dos términos anteriores y el término de ruido contribuyen a la salida. Si tanto y son positivos, la salida se asemejan a un filtro de paso bajo, con la parte de alta frecuencia del ruido disminuido. Si es positivo, mientras que es negativo, entonces el proceso favorece a los cambios en la señal entre los términos del proceso. La salida oscila.

Ejemplo: Un proceso AR(1)

Un proceso AR(1) viene dada por:

donde es un proceso de ruido blanco con media cero y varianza constante . (Nota: El subíndice de fue eliminado.) El proceso es en todo sentido estacionaria si ya que se obtiene como la salida de un filtro estable cuya entrada es ruido blanco. (Si entonces tiene varianza infinita, y por lo tanto no es estacionaria en sentido amplio.) Por lo tanto, suponiendo , la media es idéntico para todos los valores de t. Si la media se denota por , se desprende de

que

y por tanto

En particular, si , Entonces la media es 0.

La varianza es

donde es la desviación estándar de . Esto se puede demostrar por señalar que

y luego por darse cuenta de que la cantidad anterior es un punto fijo estable de esta relación.

La autocovarianza está dada por

Se puede ver que la función de autocovarianza decae con un tiempo de caída (o constante de tiempo ) de (notar que , donde K es independiente de n. Luego cuenta que y combinar esto con la ley de decaimiento exponencial ).

La densidad espectral de la función es la transformada de Fourier de la función de autocovarianza. En términos discretos este será el tiempo discreto transformada de Fourier:

Esta expresión es periódica debido a la naturaleza discreta de la , Lo que se manifiesta como la expresión del coseno en el denominador. Si asumimos que el tiempo de muestreo es mucho menor que el tiempo de decaimiento , entonces podemos utilizar una aproximación continua:

que se obtiene un perfil de Lorentz para la densidad espectral:

donde es la frecuencia angular asociada a la constante de tiempo .

Una expresión alternativa para pueden ser derivados por primera sustitución para en la ecuación de definición. Continuar con este proceso N veces los rendimientos

Para N tendiendo a infinito, se acercará a cero y

Se ve que es ruido blanco convolución con la núcleo más la media constante. Si el ruido blanco es un proceso Gaussiano luego es también un proceso Gaussiano. En otros casos, el teorema del límite central indica que se distribuirán aproximadamente normal cuando es cercano a uno.

Elección de Rezagos

Cálculo de los parámetros AR

Hay muchas formas de calcular los coeficientes, como el de mínimos cuadrados ordinarios procedimiento, método de momentos (a través de ecuaciones de Yule Walker), o cadena de Markov Monte Carlo métodos.

El modelo AR (P) es dada por la ecuación

Se basa en los parámetros de donde i = 1, ..., p. Existe una correspondencia directa entre estos parámetros y la función de covarianza del proceso, y esta correspondencia puede ser invertida para determinar los parámetros de la función de autocorrelación (que es obtenido a partir de las covarianzas). Esto se hace utilizando las ecuaciones de Yule-Walker.

Ecuaciones de Yule-Walker

Las ecuaciones de Yule-Walker son el siguiente conjunto de ecuaciones.[1]

donde m = 0, ..., p, produciendo p + 1 ecuaciones. Aquí es la función de autocovarianza de Xt, es la desviación estándar del proceso de ruido de entrada, y es la función delta de Kronecker.

Debido a que la última parte de una ecuación individuo es distinto de cero sólo si m = 0, el conjunto de ecuaciones se puede resolver mediante la representación de las ecuaciones para m> 0 en forma de matriz, consiguiendo de este modo la ecuación

que puede ser resuelto para todos La ecuación restante para m = 0 es

que, una vez son conocidos, pueden ser resueltos por

Una formulación alternativa es en términos de la función de autocorrelación . Los parámetros AR se determinan por la primera p 1 elementos \ Rho (\ tau) de la función de autocorrelación. La función de autocorrelación completo puede luego ser derivada de forma recursiva mediante el cálculo de:[2]

Ejemplos de algunos AR baja para los procesos (p)

- p=1

- Hence

- p=2

- The Yule-Walker equations for an AR(2) process are

- Remember that

- Using the first equation yields

- Using the recursion formula yields

- The Yule-Walker equations for an AR(2) process are

Estimación de parámetros AR

Las ecuaciones anteriores (las ecuaciones de Yule-Walker) proporcionan varias rutas a la estimación de los parámetros de un AR (p) del modelo, mediante la sustitución de las covarianzas teóricas con valores estimados [. cita requerida ] Algunas de estas variantes se puede describir de la siguiente manera:

- Estimación de autocovarianzas o autocorrelaciones. Aquí cada uno de estos términos se estima por separado, utilizando estimaciones convencionales. Hay diferentes maneras de hacerlo y la elección entre estos afectos a las propiedades del esquema de estimación. Por ejemplo, las estimaciones negativas de la varianza se pueden producir por algunas opciones.

- Formulación como una regresión de mínimos cuadrados problema en el que se construyó un problema de predicción de mínimos cuadrados ordinarios, basando la predicción de los valores de X t en los p valores anteriores de la misma serie. Esto puede ser pensado como un plan con visión de predicción. Las ecuaciones normales para este problema se puede ver que corresponden a una aproximación de la forma de la matriz de las ecuaciones de Yule-Walker en el que cada aparición de un autocovarianza de la misma retardo se sustituye por una estimación ligeramente diferente.

- Formulación como una forma extendida de un problema de mínimos cuadrados ordinarios predicción. Aquí dos conjuntos de ecuaciones de predicción se combinan en un solo régimen de estimación y un único conjunto de ecuaciones normales. Un grupo es el conjunto de ecuaciones de predicción hacia adelante y el otro es un conjunto correspondiente de ecuaciones de predicción hacia atrás, en relación con la representación de retroceso del modelo AR:

Aquí predicho de valores de Xt se basaría en los p valores futuros de la misma serie. Esta forma de estimación de los parámetros AR se debe a Burg,[3] y llame al método Burg:[4] Burg y autores posteriores llamadas estas estimaciones particulares "estima de máxima entropía",[5] pero el razonamiento detrás de esto se aplica a la utilización de cualquier conjunto de parámetros AR estimados. En comparación con el sistema de estimación utilizando sólo las ecuaciones de predicción hacia delante, se producen diferentes estimaciones de los autocovarianzas, y las estimaciones tienen diferentes propiedades de estabilidad. Estimaciones Burg están particularmente asociados con la estimación espectral máxima entropía.[6]

Otros posibles enfoques para la estimación incluyen estimación de máxima verosimilitud . Dos variantes distintas de máxima verosimilitud están disponibles: en uno (aproximadamente equivalente a la predicción hacia delante esquema de mínimos cuadrados) la función de probabilidad considerada es la que corresponde a la distribución condicional de los valores posteriores de la serie dado los valores de p iniciales en la serie; en el segundo, la función de probabilidad considerada es la que corresponde a la distribución incondicional conjunta de todos los valores de la serie observada. Diferencias sustanciales en los resultados de estos enfoques pueden ocurrir si la serie observada es corto, o si el proceso está cerca de no estacionariedad.

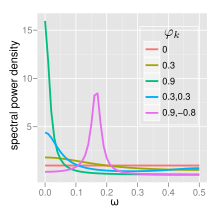

Espectro

La densidad espectral de potencia de un proceso AR(p) con la varianza del ruido is[2]

AR (0)

Para el ruido blanco (AR (0))

AR (1)

Para AR(1)

Si hay un solo pico espectral a f = 0, a menudo referido como ruido rojo . Como \ Varphi_1 se convierte más cerca de 1, hay poder más fuerte en las frecuencias bajas, el tiempo es decir, más grande se queda. Se trata entonces de un filtro de paso bajo, cuando se aplica a la luz de espectro completo, todo a excepción de la luz roja se filtra. Si hay un mínimo en f = 0, a menudo referido como ruido azul . Esta forma similar actúa como un filtro de paso alto, todo a excepción de la luz azul se filtra.

AR (2)

AR (2) Los procesos se pueden dividir en tres grupos en función de las características de sus raíces:

¿Cuándo , el proceso tiene un par de raíces complejos conjugados, la creación de un pico de frecuencia media en:

De lo contrario, el proceso tiene raíces reales, y:

¿Cuándo que actúa como un filtro de paso bajo en el ruido blanco con un pico espectral a f = 0 ¿Cuándo que actúa como un filtro de paso alto en el ruido blanco con un pico espectral a .

El proceso es estacionario cuando las raíces están fuera del círculo unitario. El proceso es estable cuando las raíces están dentro del círculo unitario, o de manera equivalente, cuando los coeficientes son en el triángulo .

La función PSD completa se puede expresar en forma real como:

Referencias

- ↑ Basu, S., & Reinsel, G. C. (1992). A note on properties of spatial Yule-Walker estimators. Journal of statistical computation and simulation, 41(3-4), 243-255.

- ↑ a b Von Storch, H.; F. W Zwiers (2001). Statistical analysis in climate research. Cambridge Univ Pr. ISBN 0-521-01230-9.[página requerida]

- ↑ Error en la cita: Etiqueta

<ref>no válida; no se ha definido el contenido de las referencias llamadasBurg - ↑ Error en la cita: Etiqueta

<ref>no válida; no se ha definido el contenido de las referencias llamadasBrockwell - ↑ Error en la cita: Etiqueta

<ref>no válida; no se ha definido el contenido de las referencias llamadasBurg1 - ↑ Error en la cita: Etiqueta

<ref>no válida; no se ha definido el contenido de las referencias llamadasBos

Bibliografía Adicional

- Mills, Terence C. (1990) Time Series Techniques for Economists. Cambridge University Press

- Percival, Donald B. and Andrew T. Walden. (1993) Spectral Analysis for Physical Applications. Cambridge University Press

- Pandit, Sudhakar M. and Wu, Shien-Ming. (1983) Time Series and System Analysis with Applications. John Wiley & Sons

- Yule, G. Udny (1927) "On a Method of Investigating Periodicities in Disturbed Series, with Special Reference to Wolfer's Sunspot Numbers", Philosophical Transactions of the Royal Society of London, Ser. A, Vol. 226, 267–298.]

- Walker, Gilbert (1931) "On Periodicity in Series of Related Terms", Proceedings of the Royal Society of London, Ser. A, Vol. 131, 518–532.