Diferencia entre revisiones de «Teoría de la información integrada»

m (Bot) Normalización de fechas |

→Visión general: Referencias evolución |

||

| Línea 17: | Línea 17: | ||

La teoría parte de dos postulados [[Fenomenología|fenomenológicos]] clave acerca de las propiedades de la experiencia subjetiva: que ésta contiene [[Teoría de la información|información]] o estructura, y que esa información a su vez está [[Emergencia (filosofía)|irreduciblemente]] integrada, en tanto que las partes de una experiencia son informativas unas de otras, haciendo imposible que un mismo sujeto se entere de dos experiencias al mismo tiempo y por separado. Mecanísticamente, esto se traduce a sistemas con símbolos o estados, pero cuya correcta transición o procesamiento de la información emerge de la conectividad o interacción causal de los componentes. |

La teoría parte de dos postulados [[Fenomenología|fenomenológicos]] clave acerca de las propiedades de la experiencia subjetiva: que ésta contiene [[Teoría de la información|información]] o estructura, y que esa información a su vez está [[Emergencia (filosofía)|irreduciblemente]] integrada, en tanto que las partes de una experiencia son informativas unas de otras, haciendo imposible que un mismo sujeto se entere de dos experiencias al mismo tiempo y por separado. Mecanísticamente, esto se traduce a sistemas con símbolos o estados, pero cuya correcta transición o procesamiento de la información emerge de la conectividad o interacción causal de los componentes. |

||

Nótese que la información a la cual la teoría se refiere no es la computada, ni la función computante, sino la contenida instrínsecamente en las conexiones del sistema físico en sí. Esto implica que a diferencia del [[Funcionalismo (filosofía)|funcionalismo]] ingenuo y del [[Teoría computacional de la mente|computacionalismo]], para ''IIT'' no todos los equivalentes conductual o computacionalmente equivalentes producen consciencia. Es decir, los [[Zombi filosófico|zombis filosóficos]] son reales. En efecto, Tononi y sus colaboradores han dado ejemplos de redes neuronales funcionalmente equivalentes pero con grados radicalmente distintos de información integrada. Se especula que la [[selección natural]] podría haber favorecido la ardua construcción de redes más integradas (y por lo tanto conscientes) en virtud de que son más compactas. |

Nótese que la información a la cual la teoría se refiere no es la computada, ni la función computante, sino la contenida instrínsecamente en las conexiones del sistema físico en sí. Esto implica que a diferencia del [[Funcionalismo (filosofía)|funcionalismo]] ingenuo y del [[Teoría computacional de la mente|computacionalismo]], para ''IIT'' no todos los equivalentes conductual o computacionalmente equivalentes producen consciencia. Es decir, los [[Zombi filosófico|zombis filosóficos]] son reales. En efecto, Tononi y sus colaboradores han dado ejemplos de redes neuronales funcionalmente equivalentes pero con grados radicalmente distintos de información integrada. Se especula que la [[selección natural]] podría haber favorecido la ardua construcción de redes más integradas (y por lo tanto conscientes) en virtud de que son más compactas.<ref>{{Cita publicación|url=http://journals.plos.org/ploscompbiol/article?id=10.1371/journal.pcbi.1002236|título=Integrated Information Increases with Fitness in the Evolution of Animats|apellidos=Edlund|nombre=Jeffrey A.|apellidos2=Chaumont|nombre2=Nicolas|fecha=2011-10-20|publicación=PLOS Computational Biology|volumen=7|número=10|páginas=e1002236|fechaacceso=2018-04-08|idioma=en|issn=1553-7358|doi=10.1371/journal.pcbi.1002236|apellidos3=Hintze|nombre3=Arend|apellidos4=Koch|nombre4=Christof|apellidos5=Tononi|nombre5=Giulio|apellidos6=Adami|nombre6=Christoph}}</ref><ref>{{Cita publicación|url=http://journals.plos.org/ploscompbiol/article?id=10.1371/journal.pcbi.1003966|título=Evolution of Integrated Causal Structures in Animats Exposed to Environments of Increasing Complexity|apellidos=Albantakis|nombre=Larissa|apellidos2=Hintze|nombre2=Arend|fecha=2014-12-18|publicación=PLOS Computational Biology|volumen=10|número=12|páginas=e1003966|fechaacceso=2018-04-08|idioma=en|issn=1553-7358|doi=10.1371/journal.pcbi.1003966|apellidos3=Koch|nombre3=Christof|apellidos4=Adami|nombre4=Christoph|apellidos5=Tononi|nombre5=Giulio}}</ref> |

||

Dicha naturaleza implicaría que, a diferencia del [[inteligencia artificial|comportamiento inteligente]], la consciencia no puede ser sometida a simulación en [[hardware]] de poder causal diferente al del hardware original, incluso dados dispositivos [[Tesis de Church-Turing|computacionalmente equivalentes]]. En palabras de Koch, "''puedes simular un agujero negro en una computadora, pero la propiedad de deformar el espacio-tiempo no estará presente''".<ref>{{Cita noticia|apellidos=Regalado|nombre=Antonio|título=Computers Could Be Conscious|url=https://www.technologyreview.com/s/531146/what-it-will-take-for-computers-to-be-conscious/|fechaacceso=18 de febrero de 2018|periódico=MIT Technology Review|idioma=en}}</ref> La consciencia de una [[inteligencia artificial general]] (o de cualquier otro software) sería la propia de los pequeños complejos de información a nivel de [[Transistor|transistores]] en el [[circuito integrado]], a menos que se trate del [[Ingeniería neuromórfica|hardware neuromórfico]] adecuado. De esta manera ''IIT'' explica que grandes centros de procesamiento de información como el [[cerebelo]] no estén ni mínimamente [[Correlatos neurales de la consciencia|correlacionados con la producción de consciencia]], mientras que regiones con una conectividad más integradora e irreducible, como la [[Corteza cerebral|corteza]], sí lo están. |

Dicha naturaleza implicaría que, a diferencia del [[inteligencia artificial|comportamiento inteligente]], la consciencia no puede ser sometida a simulación en [[hardware]] de poder causal diferente al del hardware original, incluso dados dispositivos [[Tesis de Church-Turing|computacionalmente equivalentes]]. En palabras de Koch, "''puedes simular un agujero negro en una computadora, pero la propiedad de deformar el espacio-tiempo no estará presente''".<ref>{{Cita noticia|apellidos=Regalado|nombre=Antonio|título=Computers Could Be Conscious|url=https://www.technologyreview.com/s/531146/what-it-will-take-for-computers-to-be-conscious/|fechaacceso=18 de febrero de 2018|periódico=MIT Technology Review|idioma=en}}</ref> La consciencia de una [[inteligencia artificial general]] (o de cualquier otro software) sería la propia de los pequeños complejos de información a nivel de [[Transistor|transistores]] en el [[circuito integrado]], a menos que se trate del [[Ingeniería neuromórfica|hardware neuromórfico]] adecuado. De esta manera ''IIT'' explica que grandes centros de procesamiento de información como el [[cerebelo]] no estén ni mínimamente [[Correlatos neurales de la consciencia|correlacionados con la producción de consciencia]], mientras que regiones con una conectividad más integradora e irreducible, como la [[Corteza cerebral|corteza]], sí lo están. |

||

Revisión del 00:12 8 abr 2018

La Teoría de la Información Integrada (en inglés, Integrated information theory, IIT) es una hipótesis científica y marco teórico pensado para explicar la naturaleza básica de la consciencia, propuesta originalmente en 2004 por el neurocientífico Giulio Tononi.[1][2][3] Heredera intelectual de la hipótesis del núcleo dinámico de Edelman y Tononi; a la formulación inicial de IIT han seguido otra de 2008 y una tercera, de 2014.[4] Algunos colaboradores de la teoría son Masafumi Oizumi, Larissa Albantakis, Christof Koch, Adam Barret, Anil Seth y Max Tegmark.

Dada una colección de objetos en el universo y sus interacciones, IIT pretende identificar si generan un punto de vista subjetivo, en qué grado, qué tan similar es su experiencia actual a otras; y a partir de ello propone cómo es que eventualmente se podrían hacer corresponder mediciones de estos sistemas con experiencias sensibles (qualia).

Motivación

La Teoría de la Información Integrada (IIT) intenta identificar el mecanismo fundamental (aunque no necesariamente el "propósito" evolutivo ni la necesidad lógica o metafísica) de la subjetividad o experiencia consciente. Esta forma básica de sensibilidad es descrita en la literatura filosófica como "consciencia fenoménica", o como "consciencia primaria" en palabras de Gerald Edelman. Es esta acepción la que será tratada en el presente artículo, y debe distinguirse de estados conscientes de mayor calado conceptual, como la consciencia de sí mismo descrita en la prueba del espejo.

En filosofía de la mente y ciencia cognitiva mucho se ha dicho de los límites tratando de dar cuenta de la aparición de subjetividad apelando únicamente al funcionalismo, a la manipulación sintáctica de símbolos (véase el artículo "Habitación china") o a los estados cerebrales. La Teoría de la Información Integrada pretende completar el rompecabezas de cómo es que una estructura representacional física pasa a convertirse en un estado mental pleno; con completo significado y fenomenología para el objeto (o sujeto diría IIT) experienciador.

A diferencia de otras teorías identitarias de la mente, IIT no aborda el problema difícil haciendo corresponder arbitrariamente un objeto con la subjetividad, sino partiendo de la existencia de la experiencia subjetiva como un hecho inapelable, para luego buscar las propiedades de los sistemas físicos que parecen satisfacer un sistema axiomático filosófico de la subjetividad.[2] Según Michael A. Cerullo, IIT no ataca el problema difícil tal y como fue planteado por Chalmers, sino el "problema bastante difícil" (Pretty-Hard Problem) de predecir qué objetos son a la vez mentes.[5] Chalmers por su parte ha expresado cierto entusiasmo por IIT.[6]

Visión general

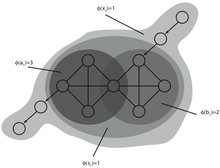

La teoría parte de dos postulados fenomenológicos clave acerca de las propiedades de la experiencia subjetiva: que ésta contiene información o estructura, y que esa información a su vez está irreduciblemente integrada, en tanto que las partes de una experiencia son informativas unas de otras, haciendo imposible que un mismo sujeto se entere de dos experiencias al mismo tiempo y por separado. Mecanísticamente, esto se traduce a sistemas con símbolos o estados, pero cuya correcta transición o procesamiento de la información emerge de la conectividad o interacción causal de los componentes.

Nótese que la información a la cual la teoría se refiere no es la computada, ni la función computante, sino la contenida instrínsecamente en las conexiones del sistema físico en sí. Esto implica que a diferencia del funcionalismo ingenuo y del computacionalismo, para IIT no todos los equivalentes conductual o computacionalmente equivalentes producen consciencia. Es decir, los zombis filosóficos son reales. En efecto, Tononi y sus colaboradores han dado ejemplos de redes neuronales funcionalmente equivalentes pero con grados radicalmente distintos de información integrada. Se especula que la selección natural podría haber favorecido la ardua construcción de redes más integradas (y por lo tanto conscientes) en virtud de que son más compactas.[7][8]

Dicha naturaleza implicaría que, a diferencia del comportamiento inteligente, la consciencia no puede ser sometida a simulación en hardware de poder causal diferente al del hardware original, incluso dados dispositivos computacionalmente equivalentes. En palabras de Koch, "puedes simular un agujero negro en una computadora, pero la propiedad de deformar el espacio-tiempo no estará presente".[9] La consciencia de una inteligencia artificial general (o de cualquier otro software) sería la propia de los pequeños complejos de información a nivel de transistores en el circuito integrado, a menos que se trate del hardware neuromórfico adecuado. De esta manera IIT explica que grandes centros de procesamiento de información como el cerebelo no estén ni mínimamente correlacionados con la producción de consciencia, mientras que regiones con una conectividad más integradora e irreducible, como la corteza, sí lo están.

Más aun, si la consciencia es emergencia de poderes causales, entonces las capacidades del mecanismo son tan importantes determinando la experiencia como el estado en sí. —El fotodiodo no siente la oscuridad en el mismo sentido que nosotros la sentimos, ya que él solo puede contrastarla contra otro estado posible.— La hipótesis predice que la mera inactivación de una neurona de por sí silenciosa puede devenir en un cambio en la percepción (aun si el estado cerebral permanece igual),[10] y que máquinas con comportamientos sumamente simples —incluso inertes— pueden experimentar cosas muy complejas. Esto le ha valido críticas, al mismo tiempo que ha sido utilizado para estimar el nivel de consciencia de pacientes paralizados.[11]

Según el neurocientífico Kristof Koch, IIT postula que las sensaciones son idénticas a la forma y medida (sujeta a otro axioma de exclusión de no-máximos locales para distinguir entre sistemas superpuestos) en la que un mecanismo físico cualquiera, no necesariamente neural o biológico, se afecta causalmente a sí mismo.[12] En este sentido, se trata de una métrica de la sinergia y una forma de complejidad. Por lo tanto su existencia no depende de observadores o mentes externas preexistentes para interpretar el contenido, como es el caso de la teoría de la información clásica de las ciencias de la computación.[13]

IIT también guarda paralelismos con el pampsiquismo, ya que propone la consciencia como una propiedad abstracta inherente en menor o mayor medida a todos los sistemas materiales.[3] Por ejemplo, según IIT el sistema de tres quarks que componen a un protón posee un poco de subjetividad (siempre y cuando no sea parte de un complejo con mayor información integrada).[6] Sin embargo, aquellas elecciones de sistemas cuyos componentes en realidad no interactúan para formar nuevos comportamientos posibles no poseen subjetividad alguna.[14] Las redes neuronales prealimentadas son ejemplos de sistemas no conscientes.

La medida de irreducibilidad del repertorio de estados del sistema, o cantidad de consciencia según IIT, es denominada Φ (phi) y se puede describir en bits usando herramientas matemáticas como la divergencia Kullback-Leibler o la "distancia del movedor de tierra"; aunque hacerlo cabalmente resulta computacionalmente intratable para sistemas suficientemente complejos, teniendo que echar mano de aproximaciones.[2] Mientras tanto, el caracter cualitativo de la experiencia con todas sus modalidades perceptuales estaría de alguna manera dado por la geometría de dicho repertorio en un espacio de la red causal denominado "espacio de los qualia". Tononi ha propuesto algunas directrices para "identificar" perceptos, modalidades sensoriales y experiencias multimodales dentro de las figuras matemáticas (llamadas conceptos) a las cuales se refiere directamente la teoría.[15]

Véase también

- Neurociencia teórica

- Problema difícil de la conciencia

- Problema alma-cuerpo

- Problema de la significación de los símbolos (en inglés)

- Binding Problem (en inglés)

- Filosofía de la mente

- Global Workspace Theory (en inglés)

Referencias

- ↑ «La conciencia como información integrada – Paradigma XXI». blogs.ciencia.unam.mx. Consultado el 17 de febrero de 2018.

- ↑ a b c «Cerebro y consciencia 1: PHI o la Teoría de la Información Integrada». Investigación y Ciencia. Consultado el 10 de marzo de 2018.

- ↑ a b «La naturaleza de la consciencia - Cuaderno de Cultura Científica». Cuaderno de Cultura Científica. Consultado el 10 de marzo de 2018.

- ↑ Oizumi, Masafumi; Albantakis, Larissa; Tononi, Giulio (8 de mayo de 2014). «From the Phenomenology to the Mechanisms of Consciousness: Integrated Information Theory 3.0». PLOS Computational Biology (en inglés) 10 (5): e1003588. ISSN 1553-7358. doi:10.1371/journal.pcbi.1003588. Consultado el 20 de marzo de 2018.

- ↑ Cerullo, Michael A. (17 de septiembre de 2015). «The Problem with Phi: A Critique of Integrated Information Theory». PLOS Computational Biology (en inglés) 11 (9): e1004286. ISSN 1553-7358. doi:10.1371/journal.pcbi.1004286. Consultado el 20 de marzo de 2018.

- ↑ a b Chalmers, David, How do you explain consciousness? (en inglés), consultado el 20 de marzo de 2018.

- ↑ Edlund, Jeffrey A.; Chaumont, Nicolas; Hintze, Arend; Koch, Christof; Tononi, Giulio; Adami, Christoph (20 de octubre de 2011). «Integrated Information Increases with Fitness in the Evolution of Animats». PLOS Computational Biology (en inglés) 7 (10): e1002236. ISSN 1553-7358. doi:10.1371/journal.pcbi.1002236. Consultado el 8 de abril de 2018.

- ↑ Albantakis, Larissa; Hintze, Arend; Koch, Christof; Adami, Christoph; Tononi, Giulio (18 de diciembre de 2014). «Evolution of Integrated Causal Structures in Animats Exposed to Environments of Increasing Complexity». PLOS Computational Biology (en inglés) 10 (12): e1003966. ISSN 1553-7358. doi:10.1371/journal.pcbi.1003966. Consultado el 8 de abril de 2018.

- ↑ Regalado, Antonio. «Computers Could Be Conscious». MIT Technology Review (en inglés). Consultado el 18 de febrero de 2018.

- ↑ Seth, Anil (1 de febrero de 2018). «Conscious spoons, really? Pushing back against panpsychism». NeuroBanter (en inglés estadounidense). Consultado el 12 de marzo de 2018.

- ↑ Horgan, John. «Can Integrated Information Theory Explain Consciousness?». Scientific American Blog Network (en inglés). Consultado el 17 de febrero de 2018.

- ↑ «La teoría de la información integrada». Investigación y Ciencia. Consultado el 17 de febrero de 2018.

- ↑ Adam Ford (26 de mayo de 2017), Christof Koch - One big misconception about consciousness, consultado el 17 de febrero de 2018.

- ↑ FQXi (25 de noviembre de 2016), Integrated Information in Brains, Machines and Natural Language by Max Tegmark, consultado el 25 de marzo de 2018.

- ↑ Balduzzi, David; Tononi, Giulio (14 de agosto de 2009). «Qualia: The Geometry of Integrated Information». PLOS Computational Biology (en inglés) 5 (8): e1000462. ISSN 1553-7358. doi:10.1371/journal.pcbi.1000462. Consultado el 17 de febrero de 2018.