Condicionamiento operante

El condicionamiento operante o condicionamiento instrumental es una forma de enseñanza mediante la cual un sujeto tiene más probabilidades de repetir las formas de conducta que conllevan consecuencias positivas, y menos probabilidad de repetir las que no conllevan dichas consecuencias o bien estas son negativas. Es un tipo de aprendizaje asociativo: en el caso del condicionamiento operante, este tiene que ver con el desarrollo de nuevas conductas en función de sus consecuencias, y no con la asociación entre estímulos y conductas como ocurre en el condicionamiento clásico.

El término fue introducido por el psicólogo Burrhus Frederic Skinner, aunque hoy se prefiere el de «condicionamiento instrumental», introducido por Edward Thorndike, por ser más descriptivo. Este último sugiere que la conducta sirve de instrumento para conseguir un fin y se da por ensayo y error, a diferencia del condicionamiento operante planteado por Skinner, que propone que aquellas respuestas que se vean reforzadas tienen tendencia a repetirse y aquellas que reciban un castigo tendrán menos probabilidad de repetirse.

La investigación sobre el condicionamiento operante ha dado lugar a una tecnología muy minuciosa para la enseñanza, denominada modificación de conducta.

Primeras investigaciones

[editar]El psicólogo Edward Thorndike (1874-1949) fue uno de los pioneros en el estudio del condicionamiento operante. Para ello, ideó sus denominadas «cajas de solución de problemas», que eran jaulas de las que las ratas (que eran los animales con los que trabajaba) podían escapar mediante acciones simples como manipular un cordón, presionar una palanca o pisar una plataforma. Como incentivo para resolver el problema, la rata podía ver y oler que fuera de la caja había comida, pero no podía alcanzarla. Al principio, la rata comenzaba a hacer movimientos azarosos, hasta que casualmente resolvía el problema, por ejemplo tirando de la polea que abría la jaula. Sin embargo, cada vez que Thorndike metía a la rata en la jaula, tardaba menos en salir. Esto se debía a que se estaba produciendo un condicionamiento operante: la conducta de tirar de la polea estaba siendo reforzada por su consecuencia (la apertura de la caja y la obtención de la comida). Esta conducta, al ser reforzada, se convertía en la conducta más probable en un futuro cuando las circunstancias eran similares.

A partir de estos experimentos, Thorndike estableció un principio que denominó Ley del efecto: «Cualquier conducta que en una situación produce un efecto satisfactorio, se hará más probable en el futuro». Si la respuesta va seguida de una consecuencia satisfactoria, la asociación entre el estímulo y la respuesta se fortalece; si a la respuesta le sigue una consecuencia desagradable, la asociación se debilita. En otras palabras, Thorndike defendía que todos los animales, incluyendo al ser humano, resuelven los problemas mediante el aprendizaje por ensayo y error.

También los estudios de Pávlov sobre condicionamiento clásico tuvieron una gran influencia en el estudio del condicionamiento operante. Si bien se trata de procesos de aprendizaje diferentes, el condicionamiento clásico y el operante comparten varios de sus principios, como la adquisición, la extinción, la discriminación o la generalización.

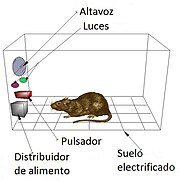

El autor más importante en el estudio del condicionamiento operante es B. F. Skinner. A finales de la década de 1920 empezó a trabajar con palomas. Para ello, utilizaba un ambiente libre de distracciones denominado caja de Skinner, en el que se podían manipular las condiciones en las que se proporcionaba alimento a los animales. Sus exhaustivos estudios utilizando este artefacto permitieron a Skinner descubrir muchos de los factores que influyen en el condicionamiento operante.

Procedimientos de condicionamiento

[editar]Existen cuatro procedimientos o tipos de condicionamiento instrumental:

- Refuerzo positivo o condicionamiento de recompensa: Un refuerzo positivo es un objeto, evento o conducta cuya presencia incrementa la frecuencia de la respuesta por parte del sujeto. Se trata del mecanismo más efectivo para hacer que tanto animales como humanos aprendan. Se denomina «refuerzo» porque aumenta la frecuencia de la conducta, y «positivo» porque el refuerzo está presente. Refuerzos positivos típicos son las alabanzas, los regalos o las aportaciones monetarias. Sin embargo, hay que tener en cuenta que en ocasiones algo que ordinariamente se considera desagradable puede funcionar como refuerzo positivo, ya que de hecho incrementa la probabilidad de la respuesta (como cuando se grita a un niño ante una rabieta, y este se siente reforzado porque así llama la atención).

- Refuerzo negativo: Un refuerzo negativo es un objeto, evento o conducta cuya retirada incrementa la frecuencia de la respuesta por parte del sujeto. Al igual que el anterior, se denomina «refuerzo» porque aumenta la frecuencia de la conducta, pero «negativo» porque la respuesta se incrementa cuando el refuerzo desaparece. En el refuerzo negativo se pueden distinguir dos procedimientos:

- Condicionamiento de escape: En este caso, la frecuencia de una respuesta aumenta porque interrumpe un estímulo aversivo, es decir, un suceso que está ocurriendo y que el sujeto considera desagradable. Un ejemplo típico sería el de un animal que aprieta una palanca porque así elimina una corriente eléctrica o el de un padre que le compra una chuchería a su hijo para dejar de oírle llorar.

- Condicionamiento de evitación: En este caso, la frecuencia de una respuesta aumenta porque pospone o evita un estímulo aversivo futuro. Un ejemplo típico sería el de un alumno que estudia para evitar una mala nota.

- Entrenamiento de omisión: Se produce cuando la respuesta operante impide la presentación de un refuerzo positivo o de un hecho agradable; es decir, consiste en retirar el estímulo positivo de una conducta para así provocar la extinción de la respuesta. Un ejemplo importante es el de «tiempo fuera», en el que se retira la atención de un niño aislándolo durante un cierto período de tiempo.

- Castigo: El castigo provoca la disminución de una conducta porque el suceso que la sigue es un estímulo aversivo. Un ejemplo típico es castigar a una rata con una pequeña corriente eléctrica cuando pulsa una palanca. Aunque el castigo puede ser en ocasiones muy eficaz para hacer que desaparezca una conducta, se recomienda utilizarlo lo menos posible, ya que tiene muchos efectos adversos o no deseados. En muchas ocasiones la conducta solo desaparece temporalmente o únicamente en los contextos en los que es probable el castigo. Además, genera gran cantidad de consecuencias secundarias (como frustración, agresividad, etc.) que pueden hacer que se detenga el proceso de aprendizaje. Por eso, en la aplicación de castigos es importante seguir ciertas reglas, como reforzar al mismo tiempo conductas alternativas a la castigada, aplicarlo inmediatamente después de la conducta que se quiere suprimir, o ser constante (ya que castigar una conducta solo a veces produce un efecto contrario al que se desea).

Tipos de refuerzos

[editar]Lo que es o no es un refuerzo durante el condicionamiento operante depende del individuo y de las circunstancias en que se encuentra en ese momento. Por ejemplo, unas galletas pueden suponer un refuerzo para un perro hambriento, pero no para uno que acaba de comer carne.

Los refuerzos se pueden dividir en dos grandes grupos: los primarios o intrínsecos y los secundarios o extrínsecos.

- Se dice que un reforzador es primario o intrínseco cuando la respuesta es reforzante por sí misma, es decir, cuando la respuesta es en sí una fuente de sensaciones agradables y la acción se fortalece automáticamente cada vez que ocurre. Existen varios tipos de conductas que son intrínsecamente reforzantes. Por ejemplo, las respuestas que satisfacen necesidades fisiológicas, como beber cuando se tiene sed o comer cuando se tiene hambre, son intrínsecamente agradables para la mayoría de los organismos. Muchas actividades sociales o que brindan estimulación sensorial o intelectual son también con frecuencia intrínsecamente reforzantes, al igual que la sensación de progreso en una habilidad. También pueden ser reforzantes por sí mismas todas las conductas que ayudan a un organismo a evitar algún daño. Sin embargo, las actividades intrínsecamente gratificadoras no siempre son reforzantes desde el principio; por ejemplo, se necesita cierta habilidad antes de que una actividad que requiere competencia (como tocar un instrumento musical, por ejemplo) se vuelva inherentemente satisfactoria.

- Los refuerzos secundarios o extrínsecos, también llamados reforzadores condicionados, son aprendidos, y en ellos el premio o gratificación no es parte de la actividad misma, sino que obtienen su carácter de refuerzo por asociación con un reforzador primario. En caso de que un reforzador condicionado se asocie con más de un reforzador primario, decimos que aquel se generaliza y es denominado reforzador generalizado. Por ejemplo, las recompensas monetarias se convierten en refuerzo porque permiten a su vez conseguir refuerzos primarios. Un tipo de reforzadores extrínsecos especialmente importante, que pueden influir enormemente cuando se trata de modificar la conducta humana, son los reforzadores sociales como el afecto, la atención, la aprobación o la sumisión.[1]

En la vida real, diversos reforzadores intrínsecos y extrínsecos se encuentran habitualmente entremezclados en un mismo suceso reforzante.

Principios del condicionamiento operante

[editar]- Adquisición: La adquisición de la respuesta se refiere a la fase del aprendizaje en que la respuesta es seguida por reforzadores. Durante la adquisición la respuesta se vuelve más fuerte o más frecuente, debido a su relación con la consecuencia reforzante.

- Generalización: Las respuestas fortalecidas mediante procedimientos operantes en un conjunto de circunstancias tienden a extenderse o a generalizarse en situaciones similares, al igual que ocurre en el condicionamiento clásico. Cuando más parecidos sean los contextos, más probable es la generalización.

- Discriminación: Los individuos desarrollan también discriminaciones al reforzarse las respuestas en una situación, pero no en otra.

- Extinción: Cuando se retira el reforzamiento para alguna respuesta particular, dicha conducta disminuye su frecuencia gradualmente hasta que solo ocurre con la misma frecuencia con que ocurría antes del reforzamiento. Sin embargo, es importante advertir que en muchas ocasiones, después de que se retiren los reforzadores, se advierte inicialmente un aumento de la cantidad de respuesta y de la frustración antes de que empiece la disminución.

- Recuperación espontánea: Al igual que en el condicionamiento clásico, las respuestas que se han extinguido vuelven a aparecer algunas veces, es decir, se da una recuperación espontánea después de un descanso.

Programas de reforzamiento

[editar]Los programas de reforzamiento son reglas que indican el momento y la forma en que la aparición de la respuesta va a ir seguida de un reforzador sobre la administración del reforzador. Estos programas influyen en distintos aspectos del aprendizaje, como la rapidez con la que se aprende inicialmente la respuesta, la frecuencia con la que se ejecuta la respuesta aprendida, la frecuencia con la que se hacen las pausas después de los reforzamientos, o el tiempo que se sigue ejecutando la respuesta una vez que el refuerzo deja de ser predecible o se suspende.

Existen dos tipos básicos de reforzamiento: el reforzamiento continuo y el reforzamiento intermitente. En el reforzamiento continuo cada una de las respuestas da lugar a la aparición de un reforzador, como en el caso de una paloma que recibe comida cada vez que picotea una tecla. Este tipo de reforzamiento parece ser el modo más eficaz para condicionar inicialmente la conducta. Sin embargo, cuando el refuerzo cesa (por ejemplo, cuando desconectamos la entrega de alimento) la extinción también es rápida. Por su parte, en el reforzamiento intermitente las respuestas solo se refuerzan algunas veces, como en el caso de una persona que juega a las máquinas y recibe el refuerzo o premio cada varias jugadas. Este tipo de programa produce un patrón más persistente de respuestas que un programa continuo cuando el reforzamiento se vuelve impredecible o cesa. Una combinación de reforzamiento intermitente y de refuerzo continuo es muy eficaz cuando se trata de enseñar a los sujetos mediante condicionamiento operante: al principio se utiliza un reforzamiento continuo, para que se adquiera la respuesta, y luego se pasa a un reforzamiento intermitente, para que sea más difícil que se extinga.

El reforzamiento intermitente da lugar a los programas de reforzamiento, que pueden ser de dos tipos: de razón (en función del número de respuestas) y de intervalo (en función del tiempo). A su vez, cada uno de ellos admite dos tipos de administración: fija o variable.

- Razón fija: El refuerzo se obtiene después de un número fijo de respuestas. Un ejemplo se da cuando las fábricas pagan a sus obreros después de producir un determinado número de productos. En realidad, el reforzamiento continuo es un programa de este tipo de razón 1. Los individuos responden con una tasa relativamente mayor de respuestas cuando operan bajo programas de razón fija superior a 1 (dependerá del caso aplicar la razón más adecuada), pero por lo general hacen una pausa para descansar después de recibir el reforzamiento, antes de proseguir con la respuesta.

- Razón variable: En este caso, el número de respuestas para conseguir el reforzador varía aleatoriamente, aunque siempre dentro de un promedio determinado. Un ejemplo son las máquinas tragamonedas, que están programadas para otorgar el premio conforme a un programa de razón variable. Muchos reforzadores naturales, como el éxito o el reconocimiento, se acercan mucho a este tipo de programas. Los programas de razón variable producen una tasa de respuesta global elevada sostenida, y los individuos no hacen pausa después del refuerzo. Aparentemente, la incertidumbre de no saber cuándo va a llegar el siguiente reforzador mantiene a los organismos produciendo la respuesta constantemente.

- Intervalo fijo: El refuerzo aparece cada vez que trascurre una determinada cantidad de tiempo, siempre que durante el intervalo se haya dado la respuesta. Un ejemplo sería el de un padre que verifica cada media hora que su hijo está estudiando, y cuando es así le hace un halago. Los programas de intervalo fijo producen una tasa de respuestas desigual. Una vez que se administra el refuerzo, la tasa de respuestas tiende a ser baja. Durante el intervalo, la conducta aumenta típicamente hasta alcanzar un nivel elevado inmediatamente antes del siguiente reforzador programado. La cantidad global de respuestas en un programa de intervalos fijos es moderada.

- Intervalo variable: El refuerzo está disponible después de un tiempo que varía aleatoriamente, pero alrededor de un promedio. Un ejemplo es el de un profesor que realiza exámenes sorpresa aproximadamente cada semana. Este tipo de programa por lo general produce una tasa de respuesta constante, pero moderada.

Por lo general, los programas de tasa (razón) producen una adquisición más rápida, pero fácilmente extinguible una vez suspendida la administración de reforzadores; y los de intervalo producen una adquisición más estable y resistente a la extinción. En la vida real, estos programas básicos a menudo se combinan.

Distinción entre condicionamiento clásico y operante

[editar]- En el condicionamiento clásico la asociación se da entre un estímulo condicionado y uno incondicionado. En el condicionamiento instrumental, la asociación se da entre las respuestas y las consecuencias que se derivan de ellas.

- En el condicionamiento clásico, el estímulo incondicionado no depende de la respuesta del sujeto, mientras que en el operante las consecuencias dependen de la respuesta del sujeto.

- En el condicionamiento clásico, la conducta es desencadenada por un estímulo (es involuntaria) mientras que en el operante, el organismo es quien emite la conducta en el ambiente (es voluntaria).

Referencias

[editar]- ↑ Skinner, 2022, pp. 104-108.

Bibliografía

[editar]- Alonso García, José Ignacio (2008). Psicología (3.ª edición). McGraw Hill. pp. 120-123. ISBN 978-84-481-6117-0.

- Campos, L. (1972). Diccionario de Psicología del Aprendizaje. México: Ciencia de la Conducta. pp. 120-123.

- Davidoff, Linda L. (1980). Introducción a la psicología (2.ª edición). McGraw Hill. pp. 170-197. ISBN 968-451-515-4.

- Myers, David G. (1997). Psicología (2.ª edición). Editorial Médica Panamericana. pp. 224-234. ISBN 84-7903-132-8.

- Skinner, B. F. (2022) [1953]. J. Virués Ortega; J. I. Navarro Guzmán; C. Delgado Casas, eds. Ciencia y conducta humana. ABA España. ISBN 978-84-09-40105-5.

- Tarpy, Roger M. (2003). Aprendizaje: teoría e investigación contemporáneas. Madrid: McGraw Hill. ISBN 84-481-2492-8.