Usuario:Ortega5892/Taller/Red backup

|

Esto es una página para pruebas Ortega5892. Esto es una página de usuario de Wikipedia. Esto no es un artículo enciclopédico.

|

Una red neuronal cuántica (QNN) es un modelo de red neuronal que está basado en los principios de la mecánica cuántica. Hay dos aproximaciones diferentes en la investigación de las QNN, uno explotando el procesamiento de información cuántica para mejorar los modelos de redes neuronales actuales (a veces también viceversa), y el otro que busca efectos cuánticos potenciales en el cerebro.

Redes neuronales cuánticas artificiales[editar]

En la aproximación computacional a la investigación sobre redes cuánticas neuronales,[1][2] los científicos intentan combinar los modelos de redes neuronales artificiales (que son muy utilizados en el aprendizaje automático para clasificación de patrones) con las ventajas de información cuántica para desarrollar algoritmos más eficaces (para un análisis, ver[3]). Una de las principales motivaciones para estas investigación es la dificultad de entrenar redes neuronales, especialmente en aplicaciones de macrodatos. Hay esperanzas de que ciertas características de la informática cuántica, como por ejemplo el paralelismo cuántico o los efectos de interferencia y entrelazamiento cuántico, puedan ser utilizados para obtener ventajas sobre las redes clásicas.

Puesto que la implementación de las tecnologías necesarias para la creación de una computadora cuántica siguen en una etapa embrionaria, tales modelos de redes neuronales cuánticas o bien son meramente propuestas teóricas o bien se implementan en modelos híbridos en la que la mayor parte de los cálculos los realiza una computadora clásica, mientras el dispositivo cuántico realiza una pequeña parte en la que se ha demostrado la ventaja cuántica.[4]

La investigación en torno a las redes neuronales cuánticas está dando sus primeros pasos, pero existen un alto número de propuestas con enfoques y rigor matemático muy dispares. La mayoría de ellas están basadas en la idea de reemplazar las neuronas binarias o de Macculloch-Pitt por un cúbit (a las que se puede llamar un quron), resultando en unidades neuronales que puede estar en un estado de superposición (activa y en reposo a la vez).

Idea histórica[editar]

Las primeras teorías sobre computación neuronal fueron publicadas por Subhash Kak, quien habla de la semejanza de la función de activación neuronal con la ecuación de valores propios de la mecánica cuántica.[5] Kak también habla de la aplicación de estas ideas al estudio de las funciones del cerebro y las limitaciones de esta aproximación.[6][7] Ajit Narayanan y Tammy Menneer propusieron una implementación fotónica de un modelo de red neuronal cuántica que está basado en la teoría de los múltiples universos que se derrumban en el modelo deseado tras realizar una medición.[8] Desde entonces se han publicado muchos más artículos en revistas de ciencias de la computación así como en las de física cuántica para encontrar un modelo de red neuronal cuántico óptimo.

Esquema de red neuronal cuántica[editar]

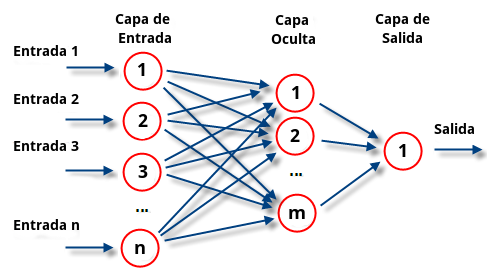

El aprendizaje automático con una red neuronal (cuántica) consta de las siguientes etapas (para más detalle ver Red neuronal artificial):

- Introducción de datos: En primer lugar se deben codificar los datos de entrada a la red.

- Procesamiento de datos: Los datos se procesan a través de las neuronas de la red utilizando unos parámetros variacionales (normalmente denominados pesos), obteniéndose uno o varios datos de salida.

- Entrenamiento: Los datos de salida se comparan con unas etiquetas asociadas a los datos de entradas que están predefinidas para calcular la función de pérdida, que mide la diferencia entre éstos. El objetivo del entrenamiento es ajustar los pesos de modo que la se obtenga la mínima pérdida, y por tanto la red ajuste de manera óptima una función entre los datos de entrada y de salida.

Existen diferentes propuestas para aplicar la mecánica cuántica en cada una de estas etapas, de manera que se pueden tener redes híbridas en las que algunas etapas son clásicas y otras son cuánticas.

Problema de la linealidad de la mecánica cuántica[editar]

Las redes neuronales tienen la capacidad de ajustar muchos tipos diferentes de funciones, para lo cual es necesario añadir un componente no lineal en el sistema. Esto se consigue aplicando una función no lineal a la salida de cada neurona, la cual se denomina función de activación. Sin embargo, la ecuación de Schrödinger, que determina la evolución de los sistemas cuánticos, es una ecuación lineal. Por tanto, todas las puertas lógicas que se emplean en la computación cuántica se basan en operadores lineales unitarios, siendo uno de los problemas principales a la hora de implementar redes neuronales cuánticas.

Existen ideas para imitar la función de activación de un perceptrón con un formalismo de mecánica cuántica, que van desde medidas especiales[9][10] hasta la postulación de operadores cuántico no lineales (un modelo matemático que está siendo rebatido).[11][12]

También se ha propuesto utilizar sistemas cuánticos abiertos. En éstos, la evolución del sistema principal junto con el entorno sigue siendo lineal, pero la evolución vista únicamente desde el sistema principal es no lineal. Esto da lugar a la Computación Cuántica Disipativa.[3][13]

Requisitos de una red neuronal cuántica[editar]

Los autores de [3] establecieron tres requisitos para que una red neuronal cuántica puede ser considerada como tal:

1. El estado inicial del sistema cuántico debe codificar una cadena binaria de longitud N.

2. La red neuronal cuántica debe reflejar uno o más aspectos de los mecanismos básicos de la computación neuronal.

3. La evolución está basada en efectos cuánticos, tales como superposición, entrelazamiento o interferencia, y debe ser totalmente consistente con la teoría cuántica.

Neuronas cuánticas y circuitos variacionales[editar]

Muchos investigadores intentan encontrar un equivalente cuántico del perceptrón, la unidad con la que se construyen las redes neuronales. Recientemente se ha propuesto una implementación sencilla de la función de activación utilizando el modelo de computación cuántica basada en circuitos por parte de Schuld, Sinayskiy y Petruccione, basándose en el algoritmo cuántico de estimación de fase.[14]

Algunas contribuciones invierten la aproximación e intentan explotar las ideas de la investigación de redes neuronales para obtener aplicaciones potentes para informática cuántica, como el diseño de algoritmos cuánticos apoyados por aprendizaje de máquinas.[15] Un ejemplo es el trabajo de Elizabeth Behrman y Jim Steck, quiénes proponen un modelo de computación cuántica que consiste en un número de cúbits con interacciones mutuas modificables.[16] Siguiendo la regla clásica de backpropagation, la fuerza de las interacciones son aprendidas de un conjunto de ejemplos entrantes, entonces la red cuántica 'aprende' un algoritmo.

Circuito RHE (RUS: Repeat Until Success en inglés). [17]

Circuito cuántico que simula neurona.

Puede entrenar sobre superposición lineal todo a la vez, de inputs con el output. De una vez.

También funciona con red de Hopfield como la feddforward red.

Typically, every neuron combines the input values through a weighted sum, applies a non-linear activation function and produces the corresponding value as output. The activation function often takes the form of a step function or, in modern uses, of a continuous sigmoid function. Its non-linearity is an essential feature that makes the collective dynamics dissipative and attractor-based [7, 8] and contributes to the ability of neural networks to capture highly non-trivial patterns [8, 9].

Los patrones atractores son para la Hopfield, que mete punto fijo.

The central issue in QNN lies in theproblem of incorporating the non-linear, dissipative dynamics of classical neural networks into the linear, unitary framework of quantum mechanics. Potential resolutions attempted so far include introducing quantum measurements [16, 17], exploiting the quadratic form of kinetic term to generate non-linearity [18], using dissipative quantum gates [16] and reversible circuits [19].

Our approach uses the recently developed repeat-until-success techniques for quantum gate synthesis [23–26].

Yo creo que lo importante es explicar la parafernalia del theta para hacer la suma donde van los parámetros, con la rotación suma, y luego que se rota con la no lineal. Que esa no lineal se consigue con un RUS, que mezcla también medida, dando no linealidad. Y referenciar los RUS. No aparecen en Wikipedia.

RUS mimetiza activación threshold, dar estado activado o no.

Usa sigmoideas o step, que es límite de la sigmoidea.

Hace clasificadores y memoria asociativa.

Del review

VQC: Circuitos cuánticos variacionales.

Those quantum gates utilizes quantum superposition

and entanglement to take an advantage over classical

computing, and

VQC usa puertas con rotaciones y parámetros libres para hacer aproximación, optimización y clasificación.

Algoritmo VQA híbrido, hace optimización clásica.

Capas de entanglement en vez de funciones de activación para tener estructura multilayer.

Rotaciones parametrizadas y entanglement gates para procesar los datos, que se codifican en los qubits. El qubit final se mide y se descodifica en output data. Los parámetros se optimizan con Adam.

Se hacen Quantum Convolutional NN. Capa a feautre map más pequeña, etc.

Aprendizaje cuántico[editar]

La mayoría de algoritmos de aprendizaje siguen el modelo clásico de entrenar una red neuronal artificial para aprender una función de entrada-salida conjunto de entrenamiento dado y utilizar unos bucles de retroalimentación clásicos para actualizar parámetros del sistema cuántico hasta que convergen a una configuración óptima. El aprendizaje como problema de optimización de parámetros también ha sido atacado por modelos adiabáticos de informática cuántica.[18]

Cómo se entrena la red, el algoritmo cuántico

Algoritmo cuántico en vez de el gradiente descencdiente, basados en el algoritmo de búsqueda de grover. [Puede que haya referencia a web de grover].

Buscar sobre todos los posibles pesos.

correctly; in other words we would like |_i = n* m, where n is the

number of training examples and m is the number of output nodes.

No entiendo qué es este producto para la rho, ósea wtf.

Se usa generalización donde el número de soluciones es desconocido [18]. Se pone estado en superposición de todos los vectores de pesos y se busca el que realiza la tarea correctamente.

No tiene por qué haber una solución que clasifique todo correctamente, de modo que se debe poner cierta tolerancia de porcentaje, clasificar cierto porcentaje.

Rho >= m*n*p: el oráculo

Second, the amount of time

needed to find a vector which correctly classifies the training set is O(p2b/t), which has

exponential complexity with respect to the number of bits in the weight vector.

Tiempo crece exponencialmente con bits que guardan los pesos. = Número de pesos.

Se propone randomizado algoritmo de entrenamiento que busca cada nodo vector de pesos independientemente, el de cada nodo. Se buscan los pesos para ese nodo con cierta p, luego iterativamente se baja p. Una vez acabado, se fijan esos pesos y se pasa a otro nodo. Así el número de pesos es poco. Los nodos no entrenados se guardan clásicamente.

Búsqueda es cuadrático speedup, el problema es exponencial. Con rándom ahora es exponencial sólo en conexiones de un nodo y no toda la red.

Se puede combinar con gradiente, uno mejorando lo del otro.

Esto es cómo hacer random walk al problema de optimización? Porque random walk es Grover, y esto es optimizar por Grover.

Quantum Neural Networks can be theoretically trained similarly to training classical/artificial neural networks. A key difference lies in communication between the layers of a neural networks. For classical neural networks, at the end of a given operation, the current perceptron copies its output to the next layer of perceptron(s) in the network. However, in a quantum neural network, where each perceptron is a qubit, this would violate the no-cloning theorem.[19][20] A proposed generalized solution to this is to replace the classical fan-out method with an arbitrary unitary that spreads out, but does not copy, the output of one qubit to the next layer of qubits. Using this fan-out Unitary () with a dummy state qubit in a known state (Ex. in the computational basis), also known as an Ancilla bit, the information from the qubit can be transferred to the next layer of qubits.[21] This process adheres to the quantum operation requirement of reversibility.[21][22]

Using this quantum feed-forward network, deep neural networks can be executed and trained efficiently. A deep neural network is essentially a network with many hidden-layers, as seen in the sample model neural network above. Since the Quantum neural network being discussed utilizes fan-out Unitary operators, and each operator only acts on its respective input, only two layers are used at any given time.[19] In other words, no Unitary operator is acting on the entire network at any given time, meaning the number of qubits required for a given step depends on the number of inputs in a given layer. Since Quantum Computers are notorious for their ability to run multiple iterations in a short period of time, the efficiency of a quantum neural network is solely dependent on the number of qubits in any given layer, and not on the depth of the network.[22]

Cost functions[editar]

To determine the effectiveness of a neural network, a cost function is used, which essentially measures the proximity of the network’s output to the expected or desired output. In a Classical Neural Network, the weights () and biases () at each step determine the outcome of the cost function .[23] When training a Classical Neural network, the weights and biases are adjusted after each iteration, and given equation 1 below, where is the desired output and is the actual output, the cost function is optimized when = 0. For a quantum neural network, the cost function is determined by measuring the fidelity of the outcome state () with the desired outcome state (), seen in Equation 2 below. In this case, the Unitary operators are adjusted after each iteration, and the cost function is optimized when C = 1.[23]

Equation 1

Equation 2

Redes neuronales híbridas[editar]

Entrenamiento clásico sobre red cuántica.

Red neuronal convolucional con convolución cuántica

Convolucional NN cuántica para clasificación de imágenes.

Algunos Q algoritmos son exponencialmente más rápidos.

NISQ: noisy intermediate-scale quantum devices

Quanvolutional NN [14]: QNN

Imagen: N*N*M; M acanales y N*N pixeles

QNN es la CNN con filtros quanvolucionales adicionales.

Los filtros procesan submuestras del tensor imagen.

Se aplica capa convolucional, con Ui(theta) a un estado de qubits, y luego se saca información clásica a un número escalar, como hace un filtro clásico. Se descodifica el codificado fautre con función user defined protocol d.

Operación cuántica se parametriza con theta, valor del pixel.

La matriz de filtrado clásicamente en CNN se entrena, es lo que multiplica a cada pixel para dar el feature en el nuevo feature mapping.

Para ser mejor la QNN

1. The quantum transformations executed on classical input data by the

quantum device are computationally intractable to calculate (or simulate)

classically.

2. The quantum transformations provide a benefit over other similar, tractable,

classical transformations.

Capas convolucionales, pooling, y fully connected.

CONV1 y POOL1 se cambian por la cuántica QUANV1. Hay otra CONV2 y POOL2.7

Rotaciones de 1 qubit con parámetro theta continuo del pixel, para no discretizar los pixeles.

NO VEO POR QUÉ ES VARIACIONAL SI DICE QUE ES EL VALOR DEL PIXEL.

No vence al clásico, pero mejora respecto a otro que hicieron.

Supremacía cuántica[editar]

Interferencia, superposición y entanglement para cálculos más potentes. Capacidad de ajustar funciones.

El codificado afecta a la capacidad y entrenabildiad.

Capacidad: cuantificación de la clases de funciones que puede ajustar [1].

Según modelo se hace más grande, el landscape de optimización se hace más flat, problema del gradient vanishing.

Entrenabilidad: capacidad de entrenar, tanto velocidad como de poder hacerlo, depende del landscape, que no tenga el flat, barren plateau.

Codificación: Hadamard a los 0 y luego RZ con angulo según valor del feature vectorial a codificar, normalziado entre -1 y 1. Entanglement con CNOT y más RRZ. Según cuanto se repita mayor profundidad del codificado, mejor entrenabilidad. El que no se puede simular clásicamente es el mejor. Esto se ha probado en PC cuántico real [ref de este paper].

El feature map es muy muy importante para que la Q gane a la C.

No se sabe por qué hacerlo como lo hacen sale así de guay.

Del review

The problem of gradient disappearance while backpropagating

Classical deep learning models solve this problem by utilizing an appropriate activation function, but quantum deep learning does not use an activation function, thus eventually, a different solution is needed.

Esto se llama barren plateaus, el problema, que aumenta exponencialmente con el número de qubits. Problema abierto.

La ventaja cuántica sólo se da bajo ciertas circunstancias.

Lógica difusa[editar]

Se ha prestado cierta atención a un modelo inspirado por la mecánica cuántica que usa ideas de la teoría cuántica para implementar una red neuronal basada en lógica difusa.[24]

Memoria asociativa cuántica.[editar]

El algoritmo de memoria cuántica asociativa ha sido introducido por Dan Ventura y Tony Martinez en 1999.[25] Los autores no intenta traducir la estructura de las redes neuronales artificiales con la teoría cuántica, sino que proponen un algoritmo para una computadora cuántica basada en circuitos que simulan memoria asociativa. Los estados de memoria (en las redes neuronales de Hopfield están guardados en los pesos de las conexiones neuronales) son escritos en una superposición, y un algoritmo de búsqueda cuántica similar al de Grover recupera el estado de la memoria más cercano a una entrada dada. Una ventaja reside en la capacidad de almacenamiento exponencial de estados de memoria, aun así la pregunta que se mantiene es si el modelo tiene significado teniendo en cuenta el propósito inicial de las redes de Hopfield como una demostración de que una red neuronal puede simular características del cerebro.

Recientemente se ha conseguido modelizar la memoria asociativa cuántica utilizando una red neuronal cuántica que cumple todos los requisitos, gracias a la aplicación de los circuitos RHE. [17]

Redes neuronales cuánticas biológicas[editar]

A pesar de que muchos investigadores de red neuronales cuánticas explícitamente limitan su alcance a una perspectiva computacional, el campo está estrechamente relacionado con investigaciones de efectos cuánticos potenciales en redes neuronales biológicas.[26][27] Modelos de memoria y agentes cognitivos basados en colectivos cuánticos han sido propuestos por Subhash Kak, pero él también señala a problemas concretos de límites de observación y control de estas memorias debido a razones lógicas fundamentales.[28][29] La combinación de la neurociencia y la física cuántica también nutre un debate vívido más allá de las fronteras de ciencia, siendo un ejemplo ilustrativo revistas como NeuroQuantology o el método de curación de Neurología Cuántica.[30][31]

Ve también[editar]

- Holographic associative Memoria

- Cognición cuántica

- Inteligencia artificial cuántica

- Aprendizaje automático cuántico

Referencias[editar]

- ↑ da Silva, Adenilton J.; Ludermir, Teresa B.; de Oliveira, Wilson R. «Quantum perceptron over a field and neural network architecture selection in a quantum computer». Neural Networks 76: 55-64. doi:10.1016/j.neunet.2016.01.002.

- ↑ Panella, Massimo; Martinelli, Giuseppe. «Neural networks with quantum architecture and quantum learning». International Journal of Circuit Theory and Applications 39: 61-77. doi:10.1002/cta.619.

- ↑ a b c M. Schuld, I. Sinayskiy, F. Petruccione: The quest for a Quantum Neural Network, Quantum Information Processing 13, 11 , pp. 2567-2586 (2014)

- ↑ language processing.

- ↑ S. Kak, On quantum neural computing, Advances in Imaging and Electron Physics 94, 259 (1995)

- ↑ S. Kak, The three languages of the brain: quantum, reorganizational, and associative.

- ↑ A. Gautam and S. Kak, Symbols, meaning, and origins of mind.

- ↑ A. Narayanan and T. Menneer: Quantum artificial neural network architectures and components, Information Sciences 128, 231-255 (2000)

- ↑ M. Perus: Neural Networks as a basis for quantum associative memory, Neural Network World 10 (6), 1001 (2000)

- ↑ M. Zak, C.P. Williams: Quantum Neural Nets, International Journal of Theoretical Physics 37(2), 651 (1998)

- ↑ S. Gupta, R. Zia: Quantum Neural Networks, Journal of Computer and System Sciences 63(3), 355 (2001)

- ↑ J. Faber, G.A. Giraldi: Quantum Models for Artificial Neural Network (2002), Electronically available: http://arquivosweb.Uso incorrecto de la plantilla enlace roto (enlace roto disponible en Internet Archive; véase el historial, la primera versión y la última). lncc.br/pdfs/QNN-Review. pdf

- ↑ 24 de esta

- ↑ M. Schuld, I. Sinayskiy, F. Petruccione: Simulating a perceptron on a quantum computer ArXiv:1412.3635 (2014)

- ↑ J. Bang et al.

- ↑ E.C. Behrman, J.E. Steck, P. Kumar, K.A. Walsh: Quantum Algorithmic design using dynamic learning, Quantum Information and Computation, vol. 8, No. 1&2, pp. 12-29 (2008)

- ↑ a b Cao, Y., Guerreschi, G. G., & Aspuru-Guzik, A. (2017). Quantum neuron: an elementary building block for machine learning on quantum computers. arXiv preprint arXiv:1711.11240..

- ↑ H. Neven et al.: Training a Binary Classifier with the Quantum Adiabatic Algorithm, arXiv:0811.0416v1 (2008)

- ↑ a b Beer, Kerstin; Bondarenko, Dmytro; Farrelly, Terry; Osborne, Tobias J.; Salzmann, Robert; Scheiermann, Daniel; Wolf, Ramona (10 de febrero de 2020). «Training deep quantum neural networks». Nature Communications (en inglés) 11 (1): 808. Bibcode:2020NatCo..11..808B. ISSN 2041-1723. PMC 7010779. PMID 32041956. arXiv:1902.10445. doi:10.1038/s41467-020-14454-2.

- ↑ Nielsen, Michael A; Chuang, Isaac L (2010). Quantum computation and quantum information (en inglés). Cambridge; New York: Cambridge University Press. ISBN 978-1-107-00217-3. OCLC 665137861.

- ↑ a b Wan, Kwok-Ho; Dahlsten, Oscar; Kristjansson, Hler; Gardner, Robert; Kim, Myungshik (2017). «Quantum generalisation of feedforward neural networks». NPJ Quantum Information 3: 36. Bibcode:2017npjQI...3...36W. S2CID 51685660. arXiv:1612.01045. doi:10.1038/s41534-017-0032-4.

- ↑ a b Feynman, Richard P. (1 de junio de 1986). «Quantum mechanical computers». Foundations of Physics (en inglés) 16 (6): 507-531. Bibcode:1986FoPh...16..507F. ISSN 1572-9516. S2CID 122076550. doi:10.1007/BF01886518.

- ↑ a b Beer, Kerstin; Bondarenko, Dmytro; Farrelly, Terry; Osborne, Tobias J.; Salzmann, Robert; Scheiermann, Daniel; Wolf, Ramona (10 de febrero de 2020). «Training deep quantum neural networks». Nature Communications (en inglés) 11 (1): 808. Bibcode:2020NatCo..11..808B. ISSN 2041-1723. PMC 7010779. PMID 32041956. arXiv:1902.10445. doi:10.1038/s41467-020-14454-2.

- ↑ G. Purushothaman, N. Karayiannis: Quantum Neural Networks (QNN’s): Inherently Fuzzy Feedforward Neural Networks, IEEE Transactions on Neural Networks, 8(3), 679 (1997)

- ↑ D. Ventura, T. Martinez: A quantum associative memory based on Grover's algorithm, Proceedings of the International Conference on Artificial Neural Networks and Genetics Algorithms, pp. 22-27 (1999)

- ↑ W. Loewenstein: Physics in mind.

- ↑ H. Stapp: Mind Matter and Quantum Mechanics, Springer, Heidelberg (2009)

- ↑ S. Kak, Biological memories and agents as quantum collectives.

- ↑ S. Kak, Observability and computability in physics, Quantum Matter 3: 172-176 (2014)

- ↑ http://www.neuroquantology.com/index.php/journal

- ↑ http://quantumneurology.com/

[[Categoría:Redes neuronales artificiales]] [[Categoría:Mecánica cuántica]]