Introducción[editar]

Uno de los problemas básicos de los Modelos Ocultos de Márkov es el cálculo de la probabilidad de una secuencia de observables  dado un modelo

dado un modelo  . El objetivo es por tanto calcular eficientemente

. El objetivo es por tanto calcular eficientemente  .

.

Probabilidad de una secuencia  de estados

de estados

Supongamos una secuencia de estados  . La probabilidad de esta secuencia es:

. La probabilidad de esta secuencia es:

Probabilidad de una secuencia de observables  dada una secuencia de estados

dada una secuencia de estados

La probabilidad de observar  cuando se da precisamente esta secuencia de estados

cuando se da precisamente esta secuencia de estados  es:

es:

Cada  corresponde con el valor de

corresponde con el valor de

Probabilidad de una secuencia de observables  dado un modelo

dado un modelo

Por tanto, para obtener la probabilidad de una secuencia  de observables dado un modelo

de observables dado un modelo  , deberíamos calcular la probabilidad de

, deberíamos calcular la probabilidad de  para cada una de las secuencias posibles

para cada una de las secuencias posibles  .

.

El cálculo de  tal y como se muestra es impracticable; sólo para

tal y como se muestra es impracticable; sólo para  estados y

estados y  observaciones sería necesario realizar del orden de

observaciones sería necesario realizar del orden de  operaciones. Para reducir esta complejidad se emplean estrategias de programación dinámica como los algoritmos forward y backward.

operaciones. Para reducir esta complejidad se emplean estrategias de programación dinámica como los algoritmos forward y backward.

Se recomienda revisar la formalización habitual de un Modelo Oculto de Márkov para comprender cada uno de los elementos en la formulación de estos dos procedimientos.

Procedimiento hacia adelante[editar]

Cálculo de  [editar]

[editar]

Consideramos la variable  como:

como:

Dado el modelo  ,

,  es la probabilidad de observar

es la probabilidad de observar  y estar en el instante de tiempo

y estar en el instante de tiempo  en el estado

en el estado  .

.

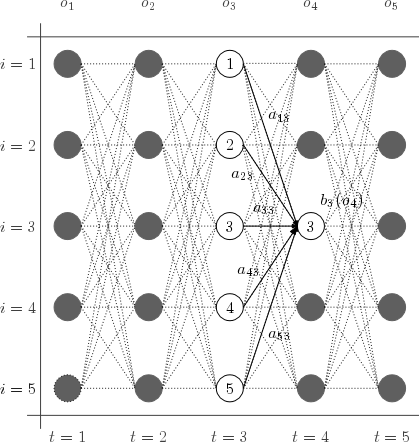

Cálculo hacia adelante de la probabilidad de una secuencia de observaciones.

Inicialización

Recurrencia

![{\displaystyle \alpha _{t+1}(j)={\biggl [}\displaystyle \sum _{i=1}^{N}{\alpha _{t}(i)a_{ij}}{\biggr ]}b_{j}(o_{t+1})}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3226e1dc082e9c82be9f84a2e92b2f2ef5e8751a)

,

,

Terminación

Ejemplo de cálculo de  [editar]

[editar]

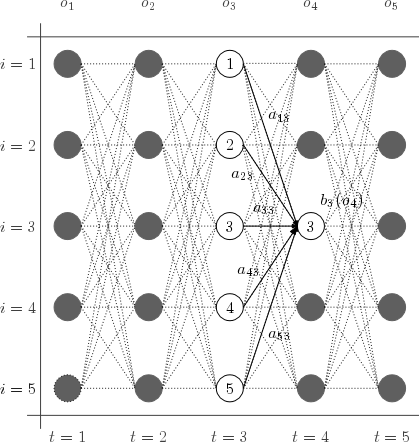

El esquema muestra los estados y probabilidades necesarias para el cálculo de  :

:

![{\displaystyle \alpha _{4}(3)={\biggl [}\displaystyle \sum _{i=1}^{5}{\alpha _{3}(i)a_{i3}}{\biggr ]}b_{3}(o_{4})}](https://wikimedia.org/api/rest_v1/media/math/render/svg/71b549caf1e5df14e80d713015e781ee2841ff92)

Cálculo hacia atrás[editar]

Cálculo de  [editar]

[editar]

Consideramos la variable  .

.

Dado el modelo  ,

,  es la probabilidad de la secuencia de observación desde el instante de tiempo

es la probabilidad de la secuencia de observación desde el instante de tiempo  hasta el final, cuando el estado en el instante de tiempo

hasta el final, cuando el estado en el instante de tiempo  es

es  .

.

Inicialización

,

,

Recurrencia

,

,

,

,

Terminación

Ejemplo de cálculo de  [editar]

[editar]

El esquema muestra los estados y probabilidades necesarios para el cálculo de  para un modelo de 5 estados y una secuencia de observaciones de longitud 5.

para un modelo de 5 estados y una secuencia de observaciones de longitud 5.

Complejidad computacional[editar]

Tanto el procedimiento hacia adelante como el algoritmo backward, requieren del orden de  operaciones; muy inferior a

operaciones; muy inferior a  operaciones (

operaciones ( es el número de estados y

es el número de estados y  es la longitud de la secuencia de observaciones) que son necesarias si se calcula

es la longitud de la secuencia de observaciones) que son necesarias si se calcula  para todas las posibles secuencias

para todas las posibles secuencias  del modelo.

del modelo.

El cálculo de los  servirán - junto a los

servirán - junto a los  - para contestar las otras dos preguntas fundamentales de los Modelos Ocultos de Márkov:

- para contestar las otras dos preguntas fundamentales de los Modelos Ocultos de Márkov:

- ¿Cuál es la secuencia óptima

de estados dado una secuencia de observaciones

de estados dado una secuencia de observaciones  ? (algoritmo de Viterbi)

? (algoritmo de Viterbi)

- Dada una secuencia de observaciones

, ¿cómo podemos estimar los parámetros del modelo

, ¿cómo podemos estimar los parámetros del modelo  para maximizar

para maximizar  . En este caso el objetivo es encontrar el modelo que mejor explica la secuencia observada (algoritmo de Baum-Welch).

. En este caso el objetivo es encontrar el modelo que mejor explica la secuencia observada (algoritmo de Baum-Welch).

Véase también[editar]

Referencias[editar]

![{\displaystyle \alpha _{t+1}(j)={\biggl [}\displaystyle \sum _{i=1}^{N}{\alpha _{t}(i)a_{ij}}{\biggr ]}b_{j}(o_{t+1})}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3226e1dc082e9c82be9f84a2e92b2f2ef5e8751a)

![{\displaystyle \alpha _{4}(3)={\biggl [}\displaystyle \sum _{i=1}^{5}{\alpha _{3}(i)a_{i3}}{\biggr ]}b_{3}(o_{4})}](https://wikimedia.org/api/rest_v1/media/math/render/svg/71b549caf1e5df14e80d713015e781ee2841ff92)