Capacidad del canal

En Ingeniería Electrónica y Teoría de la Información, la capacidad de canal es la cantidad de información que puede ser relativamente transmitida sobre canales de comunicación.

Sinopsis[editar]

La capacidad del canal se mide en bits por segundo (bps) y depende de su ancho de banda y de la relación S/N (Relación señal/ruido). La capacidad del canal limita la cantidad de información (se denomina régimen binario y se mide en bits por segundo, bps) que puede trasmitir la señal que se envía a través de él.

La capacidad máxima de un canal viene dada por la fórmula:

- (bps)

El régimen binario de una señal que se propaga por un canal no puede ser mayor que la capacidad del canal y depende del número de niveles o estados que se usan para codificar la información.

Régimen binario de la señal =

donde:

- n es el número de bits por cada elemento de la señal.

- m es el conjunto de elementos diferentes que puede adoptar la señal.

- C es la capacidad del canal según el teorema de Nyquist.

La capacidad del canal depende de la naturaleza del soporta, es decir, de los portadores canales de gran ancho de banda, como la fibra óptica, su capacidad siempre tiene un límite.

Nyquist demostró la existencia de ese límite cuando se envían señales digitales por canales analógicos.

La teoría de la información, desarrollada por Claude E. Shannon durante la Segunda Guerra Mundial, define la noción de la capacidad del canal y provee un modelo matemático con el que se puede calcular. La cifra que resulta del estado de capacidad del canal, se define como la máxima de la información mutua entre la entrada y la salida del canal. Donde el punto máximo se encuentra en la entrada de la distribución.

Definición[editar]

Al igual que todos los tipos de comunicación, mantener un diálogo con otro sistema necesita un medio físico para transmitir los datos. En el caso de la Arquitectura de Redes, a ese medio se le denomina canal.

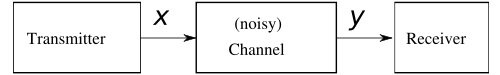

La X representa el espacio entre las señales que puede ser transmitidas y la Y el espacio de señales recibidas, durante un bloque de tiempo sobre el canal.

Con esta fórmula obtenemos la distribución condicional de la función de Y sobre X. Tratando el canal como un sistema estático conocido, pY | X(y | x), esto es una propiedad inherente del canal de comunicación (que representa la naturaleza del ruido en él). Entonces la distribución conjunta de X e Y esta completamente determinada por el canal y por la elección de la distribución marginal de las señales que nosotros elegimos enviar sobre el canal:

La distribución conjunta puede ser recuperada usando la identidad:

Sobre estas limitaciones, se debe después maximizar la cantidad de información, o de mensaje, que uno puede comunicar sobre el canal. La medida apropiada para esto es la información mutua I(X;Y), y esta máxima información mutua es el llamado canal de capacidad y viene dado por:

Tipos de canales[editar]

A continuación veremos los diferentes canales que existen:

Canal ideal: debería tener una entrada y una salida. Sin embargo, nunca está aislado totalmente del exterior y siempre se acaban introduciendo señales no deseadas que alteran en mayor o menor medida los datos que queremos enviar a través de él. Por lo tanto, esa única entrada puede producir varias salidas, y distintas entradas pueden terminar en la misma salida.

Canal discreto sin memoria: con entrada y salida discreta. Ofrecen una salida que depende exclusivamente del símbolo de entrada actual, independientemente de sus valores anteriores.

Canal binario simétrico: canal binario que puede transmitir uno de dos símbolos posibles (0 y 1). La transmisión no es perfecta, y ocasionalmente el receptor recibe el bit equivocado.

Referencia al Teorema de Nyquist[editar]

El primer teorema de Nyquist establece que, para evitar la interferencia entre símbolos de una señal que se propaga por un canal de ancho de banda, su velocidad debe ser:

Eficiencia[editar]

La eficiencia E de un canal de comunicación, es la relación entre su capacidad y su ancho de banda e indica el número de bits por segundo de información que se puede transmitir por cada herzio de su ancho de banda:

La eficiencia de un canal está establecida por el número máximo de estados distintos que puede adoptar la señal que se transmite por él para codificar la información.

La capacidad de un canal de ancho de banda determinado podría elevarse a infinito utilizando señales con un número infinito de niveles. Pero esto solo se puede obtener con un canal ideal, sin ruidos ni distorsión alguna, los cuales no existen en el mundo real.

Por tanto, el número de estados posibles está limitado por la sensibilidad y la capacidad de resolución del propio receptor para diferenciar entre niveles contiguos de la señal que recibe junto con el ruido.

Canal Ruidoso del Teorema de Codificación[editar]

Sobre este canal, la capacidad que da el canal está limitada en una velocidad de información (en unidades de información por unidad de tiempo) que puede ser alcanzado con arbitrariedad con un pequeño error de probabilidad.

El Canal Ruidoso del Teorema de Codificación de estados dice que para alguna ε > 0 y para alguna velocidad R menor que la capacidad del canal C, hay un esquema de codificación y decodificación que puede ser usado para asegurar que la probabilidad del error de bloqueo es menor que ε para un código largo.

Para velocidades mayores que la capacidad del canal, la probabilidad del error de bloqueo que recibe va de 1 hasta infinito según sea la longitud de bloqueo.

Ejemplo de aplicación[editar]

Una aplicación del concepto de capacidad de canal a un canal aditivo blanco gaussiano con B Hz de ancho de banda y señal de proporción de ruido de S/N es el Teorema de Shannon–Hartley:

C está medido en bits por segundo. Si el logaritmo está tomado en base 2, B se medirá en hercios; la señal y la potencia de ruido S y N se miden en vatios o voltios2. Entonces, la relación señal/ruido queda expresada en "veces", o "relación de potencias" y no en decibeles(dB)

Referencias[editar]

- Información mutua: https://web.archive.org/web/20080411144240/http://www.it.uc3m.es/~prometeo/trdt/html/temas/tema1/t1_4.htm

- Channel Capacity: http://en.wikipedia.org/wiki/Channel_capacity